通过Notion查看本文

本文同步发布在j000e.com

如何在Windows上运行Ollama和Open WebUI

在Windows上开始使用Ollama的逐步指南

介绍

在当今的技术环境中,大型语言模型(LLMs)已成为不可或缺的工具,能够在人类水平上执行各种任务,从文本生成到代码编写和语言翻译。然而,部署和运行这些模型通常需要大量资源和专业知识,特别是在本地环境中。这时,Ollama就派上用场了。

什么是Ollama?

Ollama是一个开源工具,旨在简化大型语言模型的本地部署和操作。它由活跃的社区维护并定期更新,提供了一个轻量且易于扩展的框架,使开发人员能够轻松地在本地机器上构建和管理LLMs。这消除了复杂的配置或依赖外部服务器的需要,使其成为各种应用的理想选择。

Ollama的主要特点

借助Ollama,开发人员可以访问和运行一系列预构建的模型,如Llama 3、Gemma和Mistral,或导入和定制自己的模型,而无需担心底层实现的复杂细节。该工具通过定义包含模型权重、配置和必要数据组件的模型文件,简化了设置过程,免去了复杂的配置文件或部署程序的需求。

本地部署的好处

Ollama使您能够本地使用开源模型。它会自动从最佳的可用存储库中获取模型,并在您的计算机拥有专用GPU时无缝地使用GPU加速,而无需手动配置。它甚至可以利用您计算机上的多个GPU,从而加快推理速度并增强资源密集型任务的性能。此外,本地运行LLMs确保您的数据永远不会离开您的计算机,这对敏感信息来说至关重要。

预期内容

本文将指导您在Windows上安装和使用Ollama,介绍其主要功能,运行多模态模型如Llama 3,使用CUDA加速,调整系统变量,加载GGUF模型,自定义模型提示,并通过Docker设置前端网站以更优雅地使用聊天机器人。它将演示如何利用其功能来探索和利用大型语言模型的强大功能。无论您是想快速体验LLMs,还是需要在本地环境中深入定制和运行模型,Ollama都提供了必要的工具和指导。

注意:运行7B模型至少需要8 GB的RAM,运行13B模型需要16 GB的RAM,运行33B模型需要32 GB的RAM。

Ollama的下载和安装

Ollama的安装过程非常简单,支持多个操作系统,包括macOS、Windows和Linux,以及Docker环境,确保广泛的可用性和灵活性。以下是Windows和macOS平台的安装指南。

您可以从官方网站或GitHub获取安装包:

Ollama下载页面截图

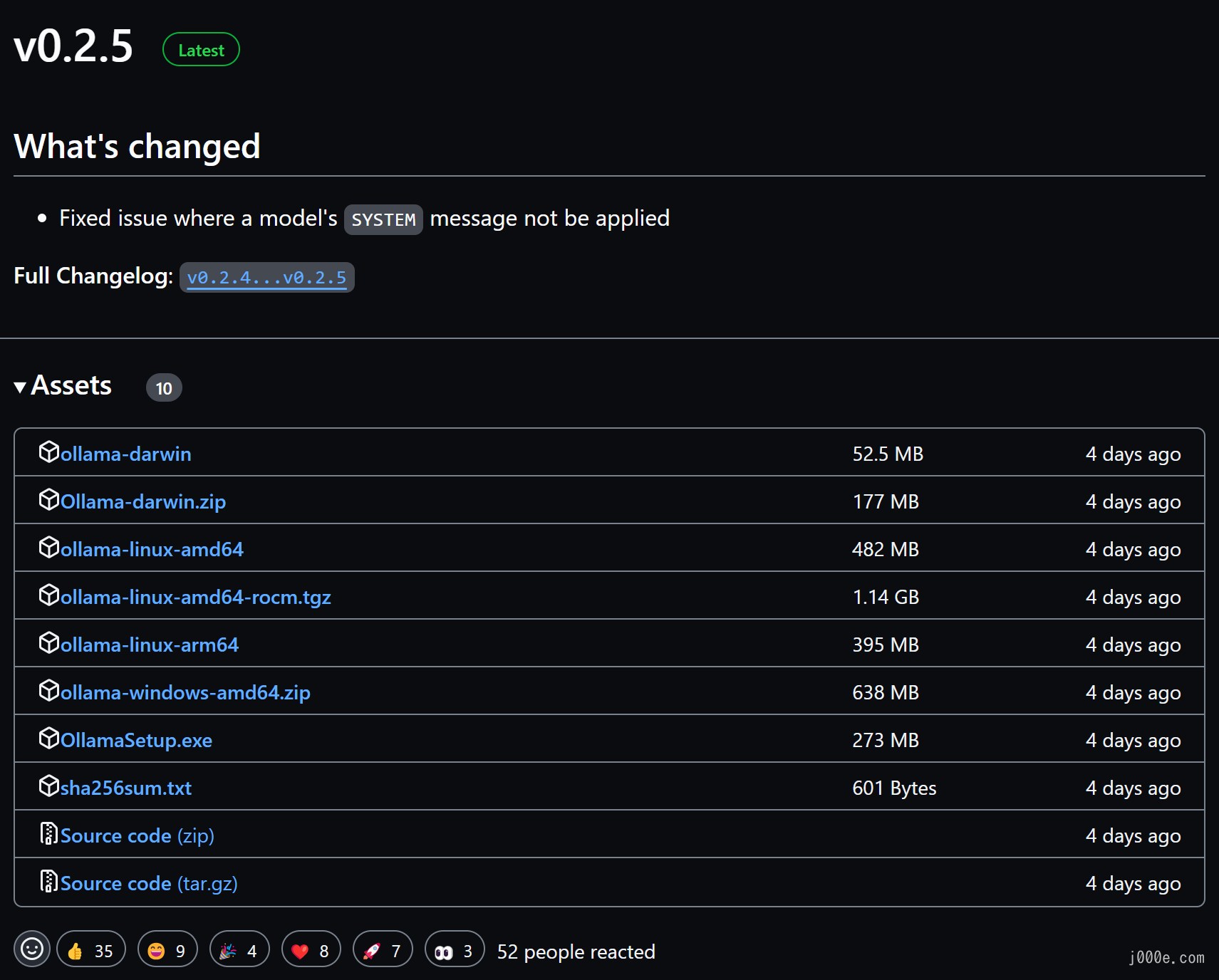

Ollama GitHub Releases

在Windows上安装Ollama

这里,我们从Ollama官方网站下载安装程序:https://ollama.com/download/OllamaSetup.exe。

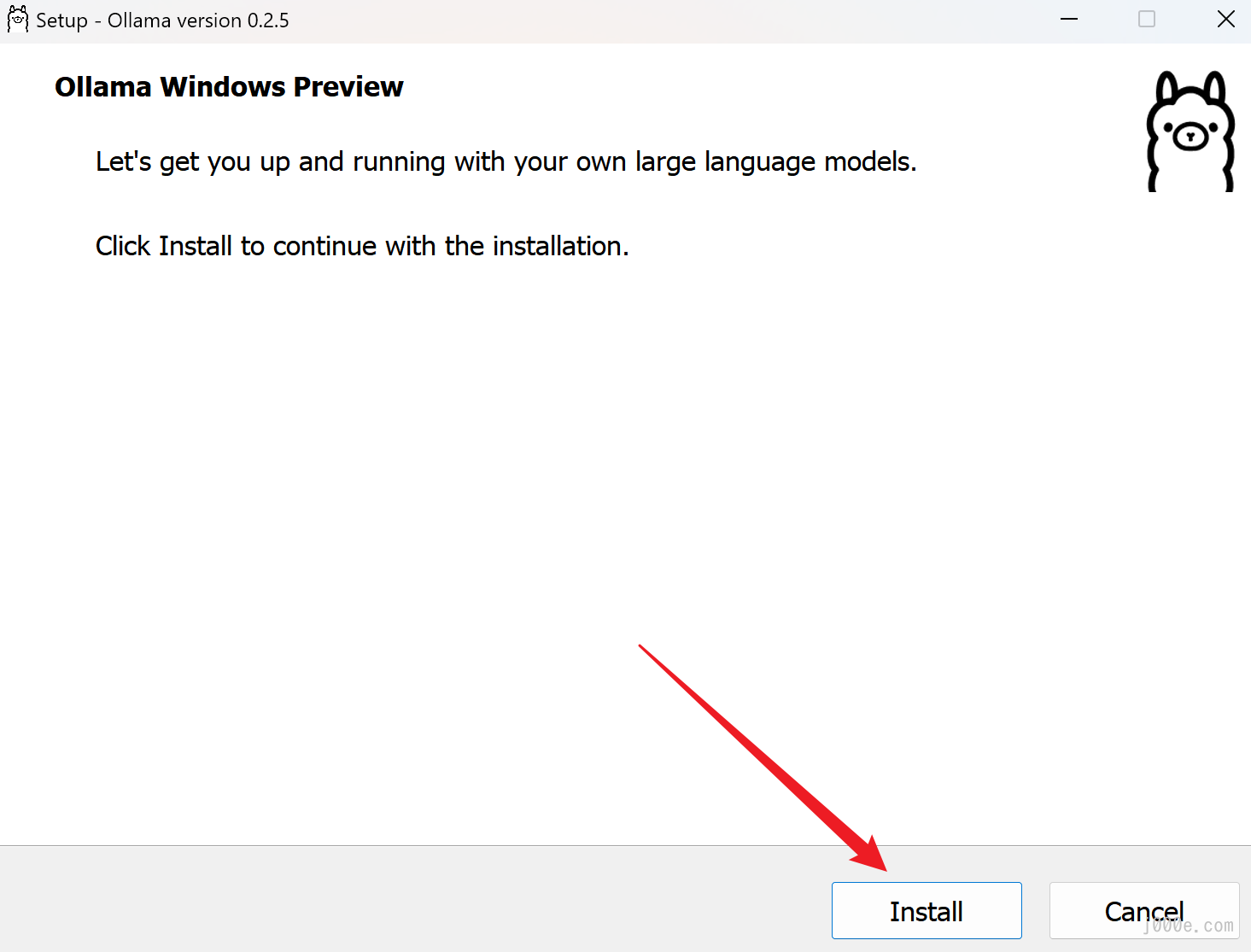

运行安装程序并点击Install。

点击Install

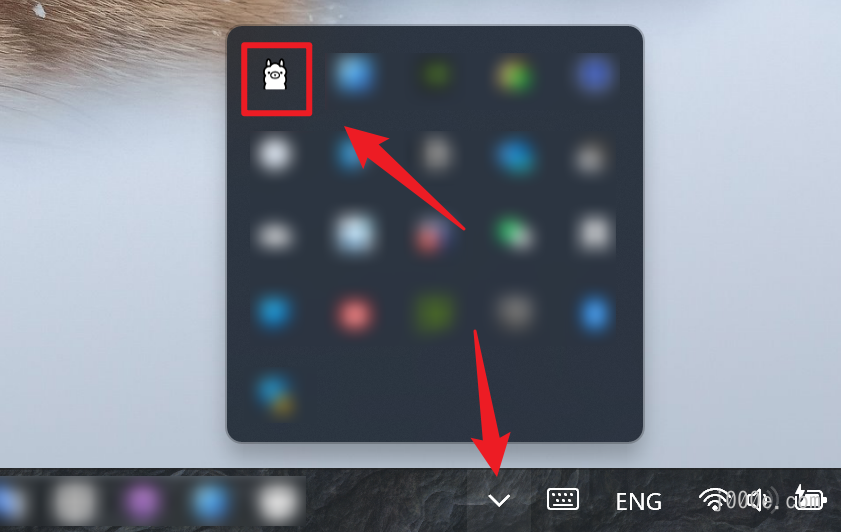

安装程序会自动执行安装任务,请耐心等待。安装完成后,安装程序窗口会自动关闭。如果您没有看到任何内容,不必担心,因为Ollama现在正在后台运行,可以在任务栏右侧的系统托盘中找到它。

安装后,您可以在系统托盘中找到正在运行的Ollama

在macOS上安装Ollama

同样,您可以从Ollama官方网站下载适用于macOS的安装程序。本文不详细介绍该平台及其他平台的安装步骤。

https://ollama.com/download/Ollama-darwin.zip

在Linux上安装Ollama

curl -fsSL https://ollama.com/install.sh | sh您可以参考官方手册了解更多详细信息:手动安装说明

通过Docker安装Ollama

官方Ollama Docker镜像 ollama/ollama在Docker Hub上可用。

docker pull ollama/ollama如何使用Ollama

本文将以Windows平台为例介绍如何使用Ollama。在macOS和其他平台上的使用方式非常相似。

自定义模型存储位置和环境变量(可选)

本节不是强制性的,跳过它不会影响您使用Ollama。

在开始使用Ollama之前,如果您的系统驱动器或分区(C:)可用空间有限,或者您更喜欢将文件存储在其他驱动器或分区上,您需要更改Ollama模型的默认存储位置。默认情况下,Ollama将下载的模型存储在C:\Users\%username%\.ollama\models,由于模型可能有几个GB大小,这可能会迅速减少系统驱动器的可用空间,可能影响系统性能。

同样地,在macOS上,模型的默认存储位置是~/.ollama/models,在Linux上则是/usr/share/ollama/.ollama/models。

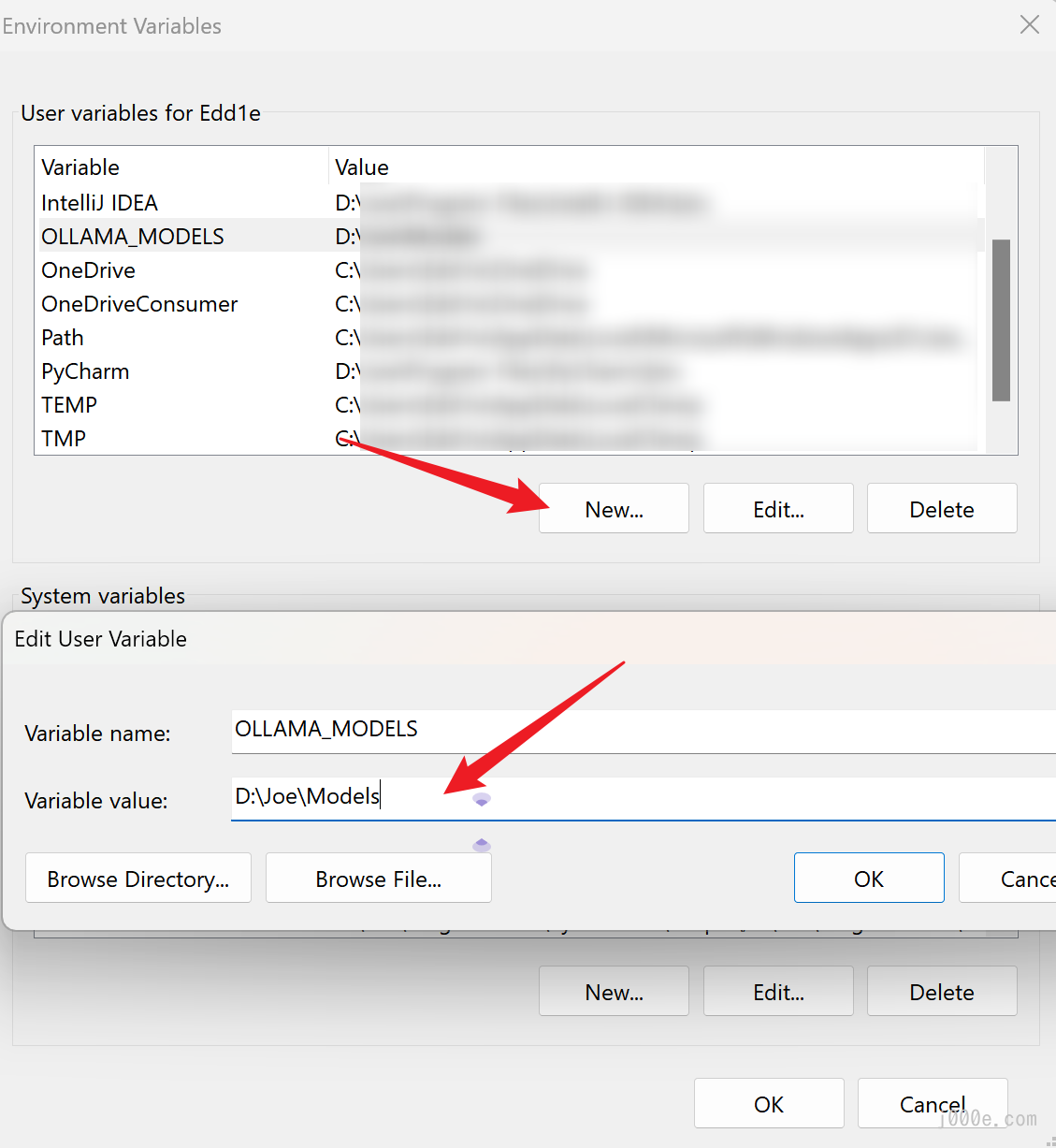

如果您需要使用不同的目录,请将环境变量OLLAMA_MODELS设置为所选目录。以下是设置方法:

在Windows上,Ollama会继承用户和系统环境变量。

- 首先通过点击任务栏中的Ollama图标退出Ollama。

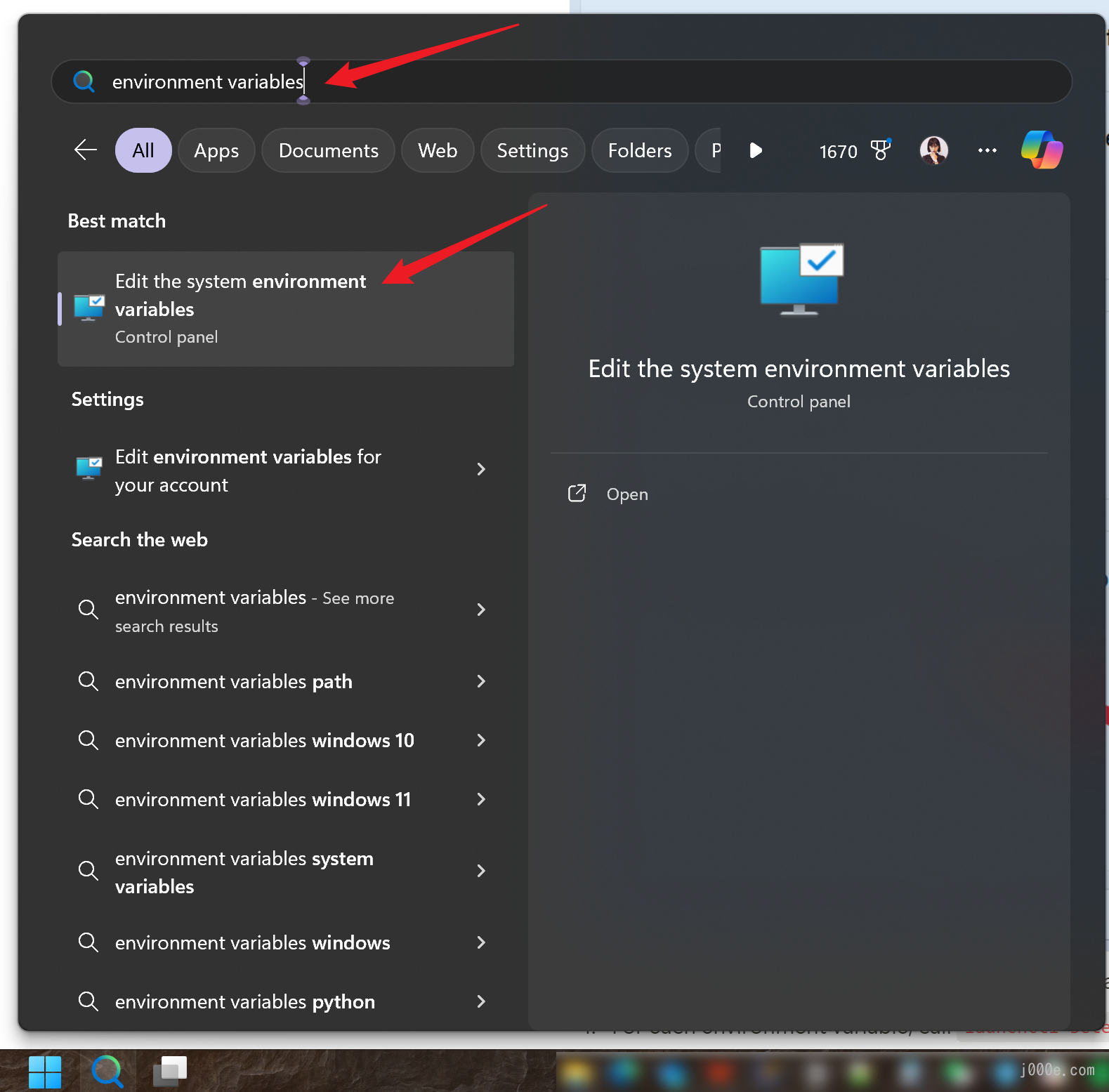

- 启动设置(Windows 11)或控制面板(Windows 10)应用程序并搜索

环境变量。 - 点击

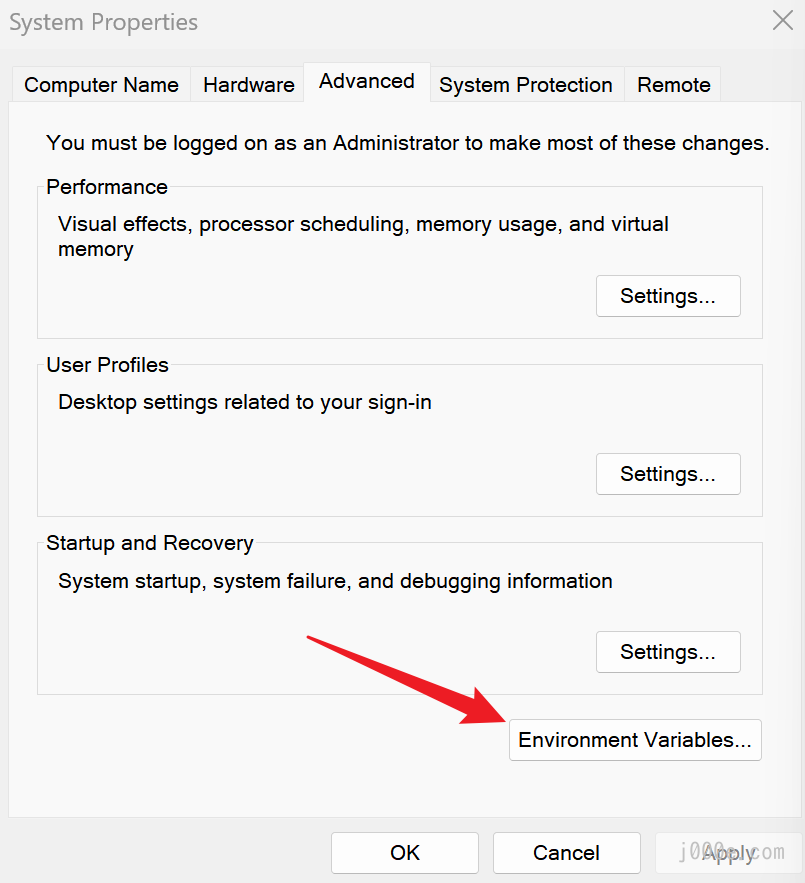

编辑系统环境变量。 - 创建一个名为

OLLAMA_MODELS的变量,指向您希望存储模型的位置。 - 点击确定/应用以保存。

- 从Windows开始菜单启动Ollama应用程序。

搜索“环境变量”

点击环境变量

创建一个名为OLLAMA_MODELS的变量,指向您希望存储模型的位置

如果Ollama作为macOS应用程序运行,则应使用launchctl设置环境变量:

对于每个环境变量,调用

launchctl setenv。launchctl setenv OLLAMA_MODELS /PATH/- 重新启动Ollama应用程序。

设置完成后,当您使用Ollama拉取模型时,它们将存储在自定义位置。

其他常用的系统环境变量可以根据需要设置(可选):

OLLAMA_HOST:Ollama服务监听的网络地址,默认为127.0.0.1。如果您希望允许其他计算机(如本地网络中的计算机)访问Ollama,可以将其设置为0.0.0.0以允许来自其他网络的访问。OLLAMA_PORT:Ollama服务监听的默认端口,默认为11434。如果存在端口冲突,可以将其更改为其他端口(如8080)。OLLAMA_ORIGINS:HTTP客户端请求来源的逗号分隔列表。如果在本地使用且没有严格要求,可以将其设置为星号(*)表示没有限制。OLLAMA_KEEP_ALIVE:大模型在内存中的保留时间,默认为5分钟(5m)。例如,纯数字如300表示300秒,0表示在处理请求后立即卸载模型,任何负数表示无限期保留模型在内存中。您可以将其设置为24h以在内存中保留模型24小时,从而提高访问速度。OLLAMA_NUM_PARALLEL:并发请求处理程序的数量,默认为1,即请求按顺序处理。根据实际需要进行调整。OLLAMA_MAX_QUEUE:请求队列的长度,默认为512。超出此长度的请求将被丢弃。根据情况调整此设置。OLLAMA_DEBUG:输出调试日志的标志。将其设置为1以输出详细的日志信息,有助于排查问题。OLLAMA_MAX_LOADED_MODELS:可以同时加载到内存中的模型最大数量,默认为1,即一次只能有一个模型在内存中。

快速开始:试用Llama 3

我们可以使用ollama run llama3命令快速体验Meta的最新开源模型Llama 3 8B。首先,打开一个命令行窗口(您可以使用cmd、PowerShell或Windows Terminal运行本文中提到的命令),并输入ollama run llama3以开始拉取模型。(如果您想体验其他模型,请参阅本文后面的“模型库”部分了解模型及其对应命令,或按照“从GGUF导入”部分加载自定义GGUF模型。)

C:\Users\Edd1e>ollama run llama3

pulling manifest

pulling 6a0746a1ec1a... 100% ▕████████████████████████████████████████████████████████▏ 4.7 GB

pulling 4fa551d4f938... 100% ▕████████████████████████████████████████████████████████▏ 12 KB

pulling 8ab4849b038c... 100% ▕████████████████████████████████████████████████████████▏ 254 B

pulling 577073ffcc6c... 100% ▕████████████████████████████████████████████████████████▏ 110 B

pulling 3f8eb4da87fa... 100% ▕████████████████████████████████████████████████████████▏ 485 B

verifying sha256 digest

writing manifest

removing any unused layers

success

>>> Send a message (/? for help)模型拉取完成后,我们可以开始使用Llama 3 8B。您可以在命令行中直接向模型发送对话内容。

例如,我们可以先问它是谁:

>>> Who are you?

I am LLaMA, an AI assistant developed by Meta AI that can understand and respond to human input in a

conversational manner. I'm not a human, but rather a computer program designed to simulate conversation and answer

questions to the best of my ability based on my training.

My primary function is to provide information and answer questions across a wide range of topics, from science and

history to entertainment and culture. I can generate text responses that are natural-sounding and often

indistinguishable from those written by humans.

I was trained using a massive dataset of text from various sources, including books, articles, and websites. This

training enables me to recognize patterns and relationships in language, allowing me to understand and respond to

user input.

Some examples of what I can do include:

1. Answering questions: I can provide information on a wide range of topics, from science and history to

entertainment and culture.

2. Generating text: I can create original text based on a prompt or topic.

3. Summarizing content: I can summarize long pieces of text into shorter, more digestible versions.

4. Offering suggestions: I can suggest ideas or options for things like travel destinations, restaurants, or books

to read.

I'm constantly learning and improving my responses based on user interactions, so please bear with me if I make

any mistakes!如您所见,Llama 3清楚地介绍了它的信息和功能。我们可以通过问两个简单的问题继续测试它:

>>> If there are 1000 books in a room and I read 2, how many books are still in the room? Answer succinctly

998 books.

>>> Why?

Because you've read 2 books, leaving 1000 - 2 = 998 books remaining in the room.

>>> 9.11 and 9.2, which is larger?

9.2 is larger than 9.11.显然,Llama 3在回答简单逻辑问题时会产生幻觉,并且在多次新的对话测试中始终提供错误答案。因此,模型生成的内容可能是错误的,不应完全相信。

Ollama模型库

想试试其他模型吗?您可以访问Ollama提供的模型列表:https://ollama.com/library。

以下是一些可以下载的示例模型:

| 模型 | 参数 | 大小 | 下载 |

|---|---|---|---|

| Llama 3 | 8B | 4.7GB | ollama run llama3 |

| Llama 3 | 70B | 40GB | ollama run llama3:70b |

| Phi 3 Mini | 3.8B | 2.3GB | ollama run phi3 |

| Phi 3 Medium | 14B | 7.9GB | ollama run phi3:medium |

| Gemma 2 | 9B | 5.5GB | ollama run gemma2 |

| Gemma 2 | 27B | 16GB | ollama run gemma2:27b |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Moondream 2 | 1.4B | 829MB | ollama run moondream |

| Neural Chat | 7B | 4.1GB | ollama run neural-chat |

| Starling | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Solar | 10.7B | 6.1GB | ollama run solar |

操作命令

在运行模型之前,您应该知道Ollama有以下命令,可以在命令行中运行这些命令以利用Ollama的各种功能:

| 命令 | 描述 | 示例 |

|---|---|---|

| serve | 启动ollama | |

| create | 从模型文件创建模型 | ollama create mymodel -f ./Modelfile |

| show | 显示模型信息 | |

| run | 运行模型 | |

| pull | 从注册表拉取模型 | ollama pull llama3 |

| push | 将模型推送到注册表 | |

| list | 列出模型 | |

| ps | 列出运行中的模型,显示硬件使用情况 | |

| cp | 复制模型 | ollama cp llama3 my-model |

| rm | 删除模型 | ollama rm llama3 |

| help | 获取命令帮助 |

pull命令也可用于更新本地模型。只会拉取差异部分。如果您想获取特定命令(如run)的帮助内容,可以输入ollama [command] --help以获取该命令的详细使用信息。例如,输入ollama run --help,您将看到:

C:\Users\Edd1e>ollama run --help

Run a model

Usage:

ollama run MODEL [PROMPT] [flags]

Flags:

--format string Response format (e.g. json)

-h, --help help for run

--insecure Use an insecure registry

--keepalive string Duration to keep a model loaded (e.g. 5m)

--nowordwrap Don't wrap words to the next line automatically

--verbose Show timings for response

Environment Variables:

OLLAMA_HOST IP Address for the ollama server (default 127.0.0.1:11434)

OLLAMA_NOHISTORY Do not preserve readline history在模型运行时,您可以执行以下操作:

| 命令 | 描述 |

|---|---|

| /set | 设置会话变量 |

| /show | 显示模型信息 |

| /load | 加载会话或模型 |

| /save | 保存当前会话 |

| /clear | 清除会话上下文 |

| /bye | 退出 |

| /?, /help | 获取命令帮助 |

| /? shortcuts | 获取快捷键帮助 |

此外,您可以使用三引号(""")开始多行消息。例如:

>>> """Hello,

... world!

... """

I'm a basic program that prints the famous "Hello, world!" message to the console.您还可以利用一些多模态模型的能力,让模型识别图像。例如,您可以使用LLaVA模型识别由DALLE-3生成的图像,只需在提示中包含图像路径:

ollama run llava

>>> What is in this image? "D:\Joe\Downloads\test.png"

Added image 'D:\Joe\Downloads\test.png'

The image shows two people taking a selfie. They are wearing face masks and appear to be in an outdoor setting,

possibly with volcanic scenery in the background. One person is holding a phone with a camera app open, while the

other has their arm around the first person's shoulder. Both individuals are dressed casually and are also wearing

what seem to be raincoats or ponchos. The photo captures a moment of travel or exploration, as indicated by the

clear sky and natural environment.

图像test.png由DALLE-3生成

可以看出,模型准确描述了图像中的细节,几乎完美地再现了我用来生成它的提示。

查看日志

有时,Ollama可能不会按预期运行。查明问题的最佳方法之一是检查日志。

在Windows上运行Ollama时,可以检查几个不同的位置。通过按Win+R打开文件资源管理器并输入以下命令:

explorer %LOCALAPPDATA%\\Ollama # View logs

explorer %LOCALAPPDATA%\\Programs\\Ollama # Browse binaries (the installer adds this to the user's PATH)

explorer %HOMEPATH%\\.ollama # Browse model and configuration storage location

explorer %TEMP% # Temporary executable files are stored in one or more ollama* directories在Mac上,您可以运行以下命令查找日志:

cat ~/.ollama/logs/server.log如果需要,您可以将环境变量OLLAMA_DEBUG设置为“1”以获取更详细的日志信息。

使用GPU加速:安装CUDA Toolkit(可选)

对于像Llama 3 8B这样的小模型,使用CPU或集成显卡可以很好地工作。然而,如果您的计算机有Nvidia独立显卡,并且您希望运行更大的模型或实现更快的响应时间,您需要安装CUDA Toolkit以更好地利用独立显卡。

注意:此步骤仅适用于具有计算能力5.0以上的Nvidia GPU。

如果您使用的是AMD GPU,您可以查看支持的设备列表以确认您的显卡是否受Ollama支持。然而,CUDA Toolkit仅适用于Nvidia GPU,所以AMD GPU用户可以跳过此部分,不会错过任何内容。

Ollama支持以下AMD GPU:

| 系列 | 显卡和加速器 |

|---|---|

| AMD Radeon RX | 7900 XTX 7900 XT 7900 GRE 7800 XT 7700 XT 7600 XT 7600 6950 XT 6900 XTX 6900XT 6800 XT 6800 Vega 64 Vega 56 |

| AMD Radeon PRO | W7900 W7800 W7700 W7600 W7500 W6900X W6800X Duo W6800X W6800 V620 V420 V340 V320 Vega II Duo Vega II VII SSG |

| AMD Instinct | MI300X MI300A MI300 MI250X MI250 MI210 MI200 MI100 MI60 MI50 |

接下来,Nvidia GPU用户应检查您的计算能力以确认您的显卡是否受支持:Nvidia CUDA GPUs

以下是支持的显卡列表:

| 计算能力 | 系列 | 显卡 |

|---|---|---|

| 9.0 | NVIDIA | H100 |

| 8.9 | GeForce RTX 40xx | RTX 4090 RTX 4080 SUPER RTX 4080 RTX 4070 Ti SUPER RTX 4070 Ti RTX 4070 SUPER RTX 4070 RTX 4060 Ti RTX 4060 |

| NVIDIA Professional | L4 L40 RTX 6000 | |

| 8.6 | GeForce RTX 30xx | RTX 3090 Ti RTX 3090 RTX 3080 Ti RTX 3080 RTX 3070 Ti RTX 3070 RTX 3060 Ti RTX 3060 |

| NVIDIA Professional | A40 RTX A6000 RTX A5000 RTX A4000 RTX A3000 RTX A2000 A10 A16 A2 | |

| 8.0 | NVIDIA | A100 A30 |

| 7.5 | GeForce GTX/RTX | GTX 1650 Ti TITAN RTX RTX 2080 Ti RTX 2080 RTX 2070 RTX 2060 |

| NVIDIA Professional | T4 RTX 5000 RTX 4000 RTX 3000 T2000 T1200 T1000 T600 T500 | |

| Quadro | RTX 8000 RTX 6000 RTX 5000 RTX 4000 | |

| 7.0 | NVIDIA | TITAN V V100 Quadro GV100 |

| 6.1 | NVIDIA TITAN | TITAN Xp TITAN X |

| GeForce GTX | GTX 1080 Ti GTX 1080 GTX 1070 Ti GTX 1070 GTX 1060 GTX 1050 Ti GTX 1050 | |

| Quadro | P6000 P5200 P4200 P3200 P5000 P4000 P3000 P2200 P2000 P1000 P620 P600 P500 P520 | |

| Tesla | P40 P4 | |

| 6.0 | NVIDIA | Tesla P100 Quadro GP100 |

| 5.2 | GeForce GTX | GTX TITAN X GTX 980 Ti GTX 980 GTX 970 GTX 960 GTX 950 |

| Quadro | M6000 24GB M6000 M5000 M5500M M4000 M2200 M2000 M620 | |

| Tesla | M60 M40 | |

| 5.0 | GeForce GTX | GTX 750 Ti GTX 750 NVS 810 |

| Quadro | K2200 K1200 K620 M1200 M520 M5000M M4000M M3000M M2000M M1000M K620M M600M M500M |

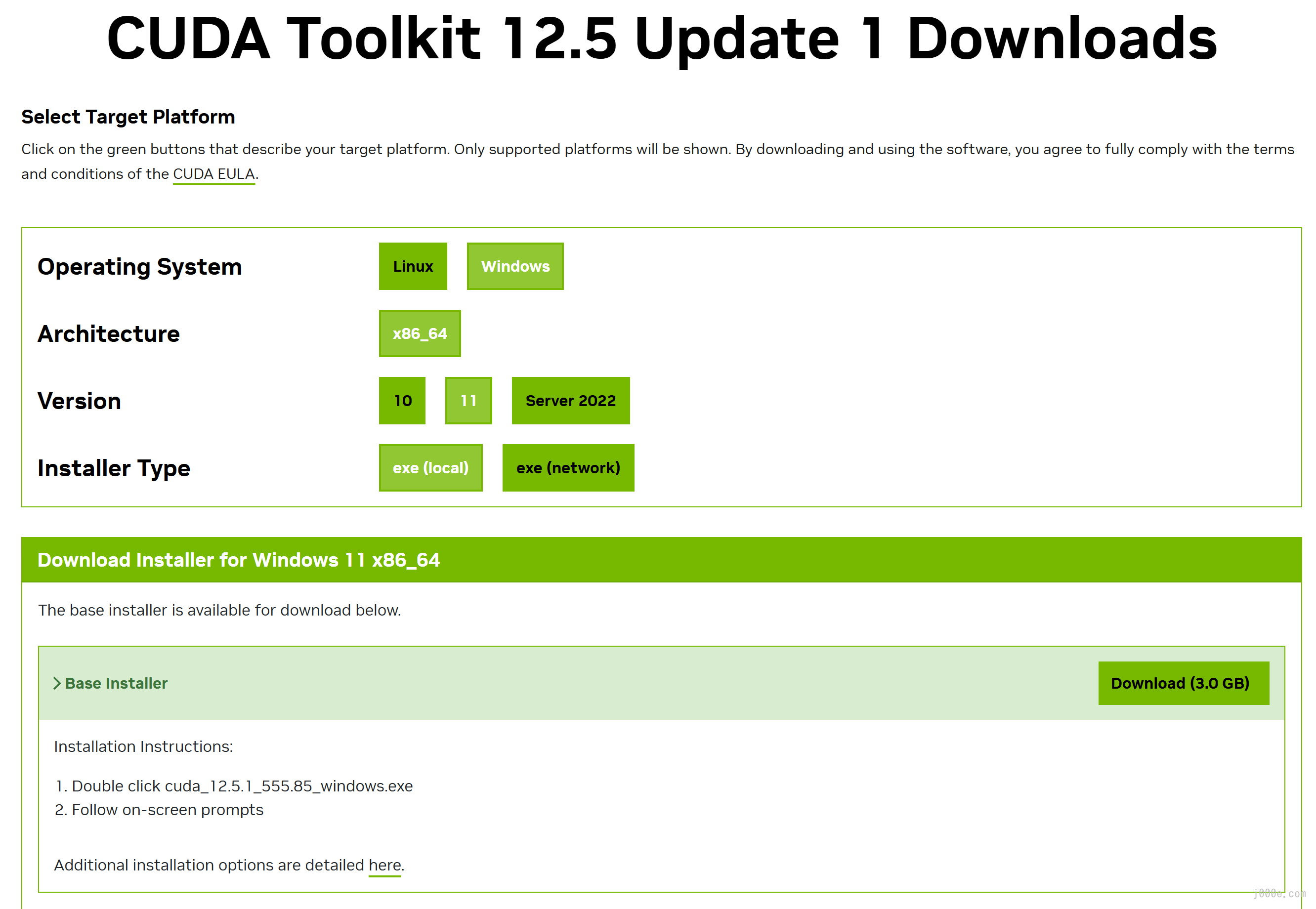

如果您的GPU受支持,您可以从以下链接下载适当的CUDA Toolkit安装程序:

选择与您的系统和架构匹配的版本:

下载适用于Windows x64架构的CUDA安装程序

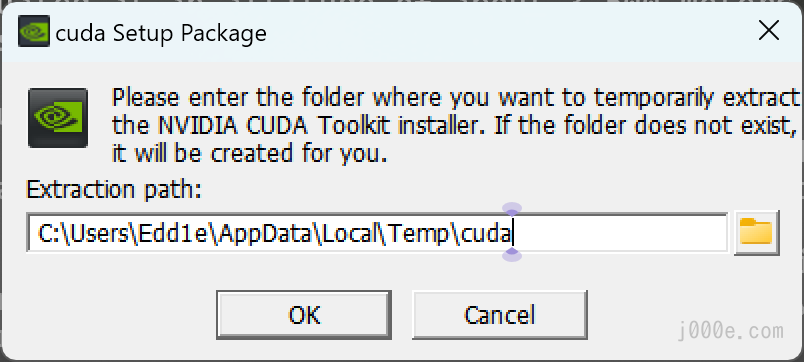

运行安装程序并点击确定:

运行CUDA安装包

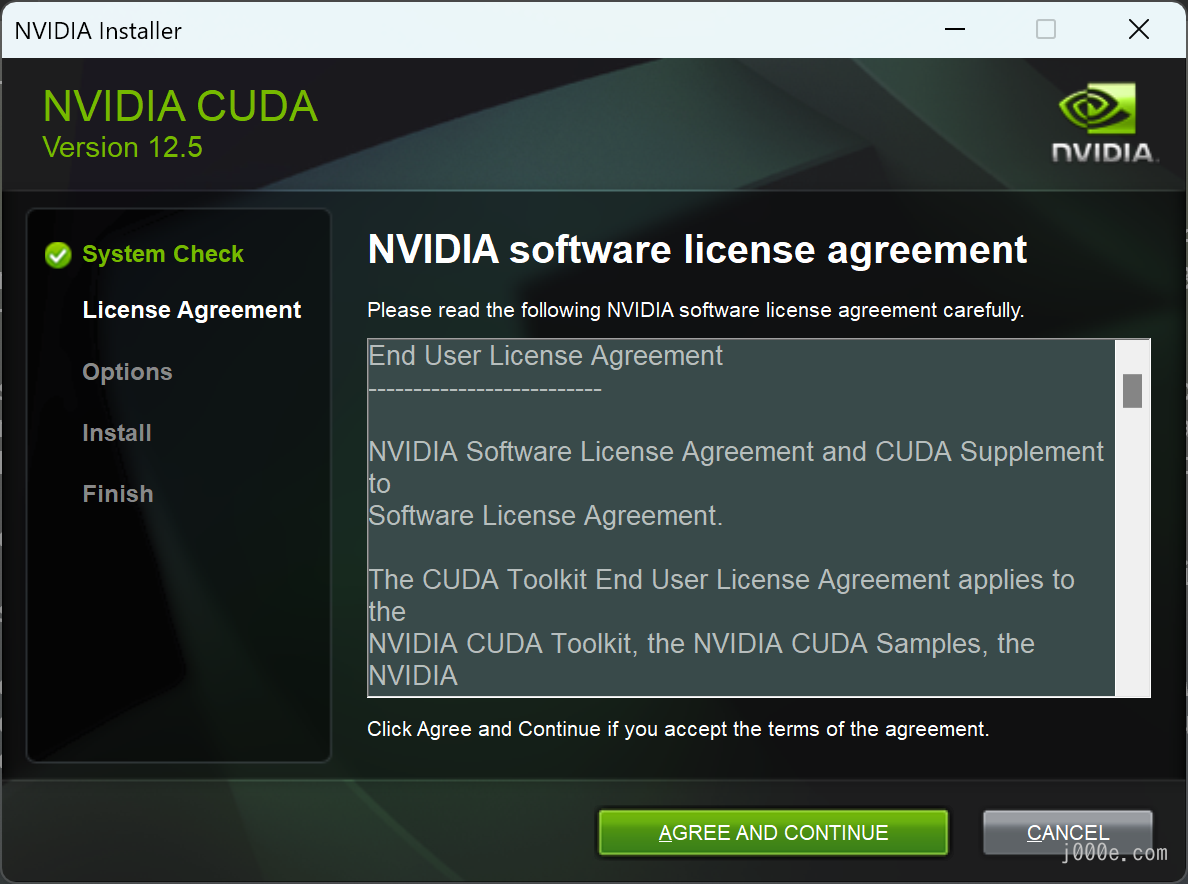

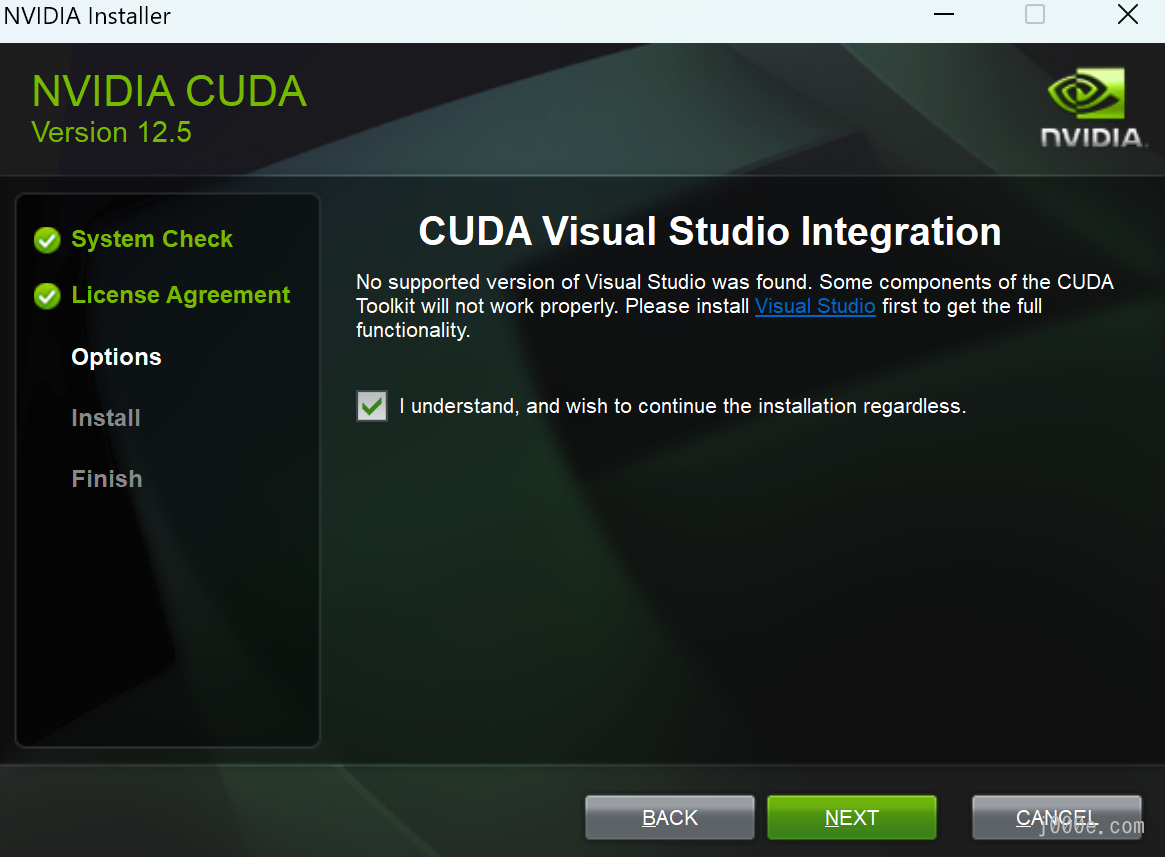

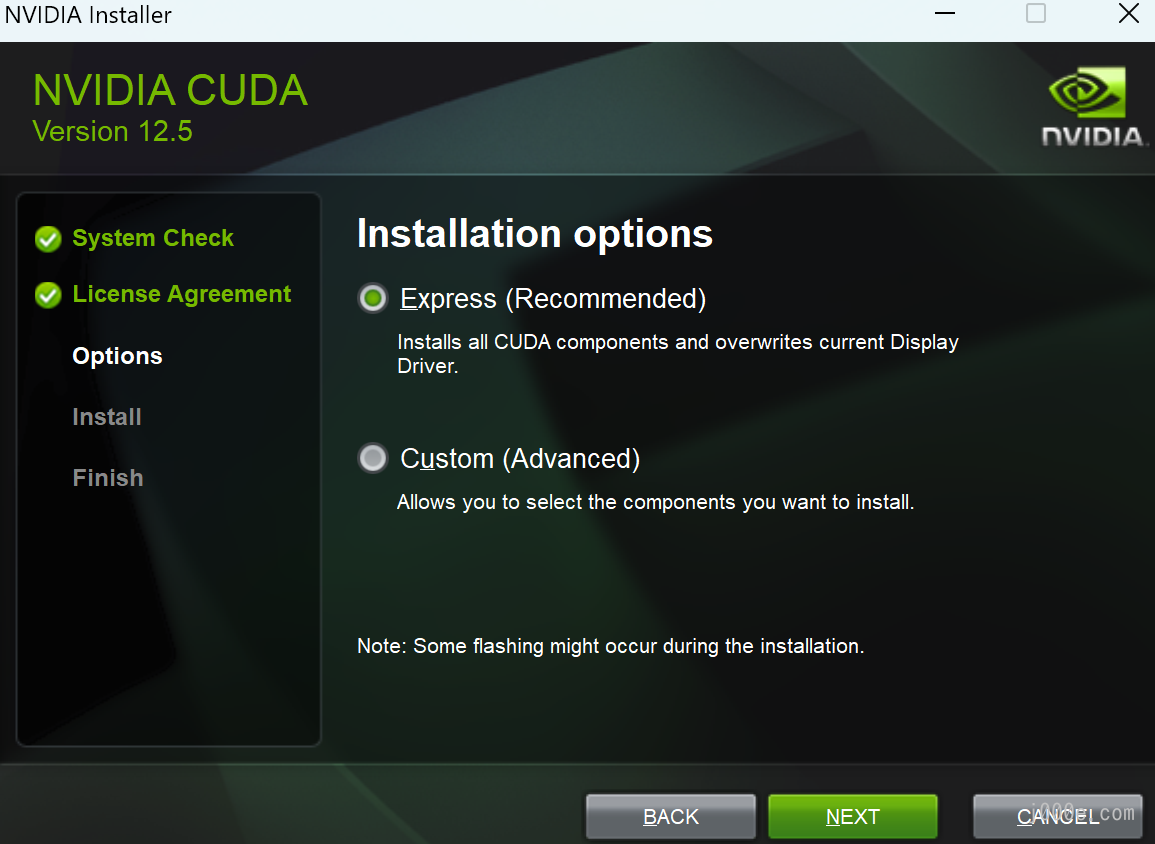

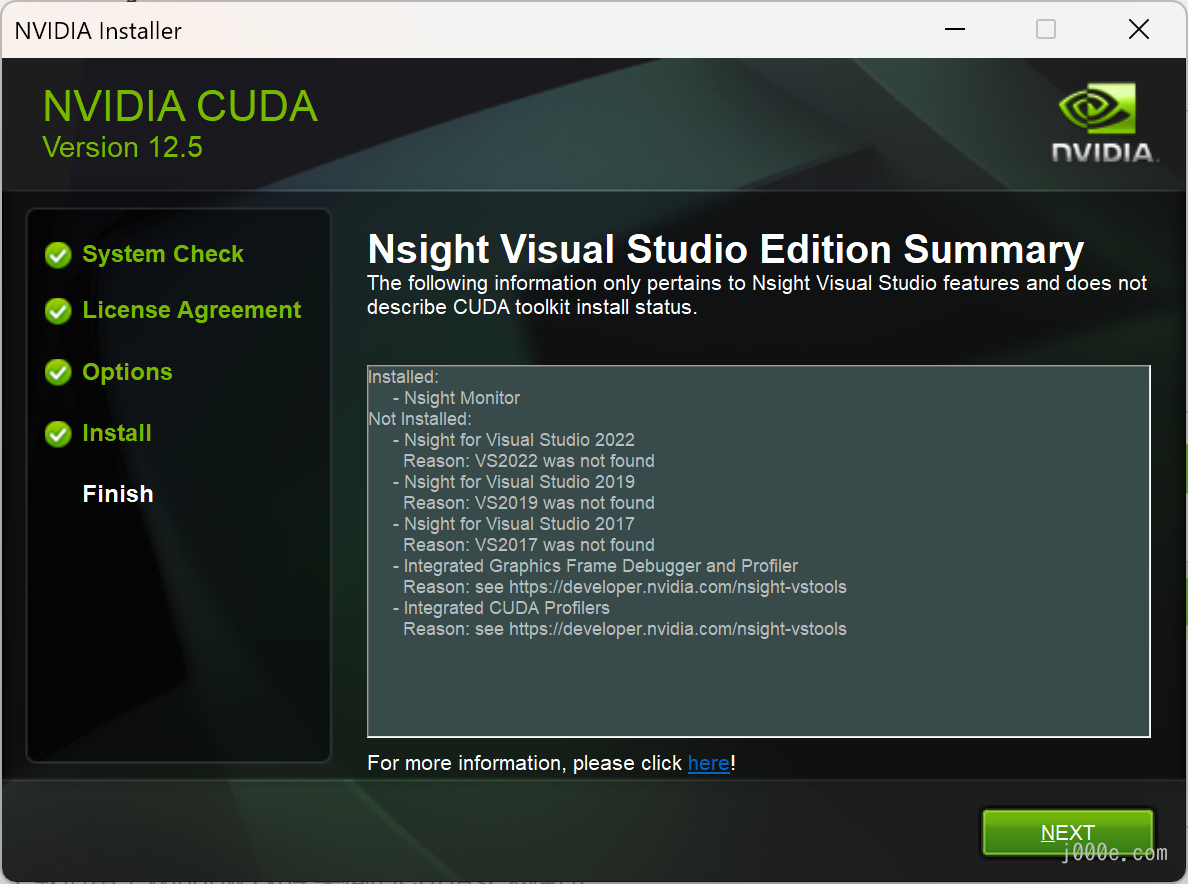

按照安装程序的说明完成安装:

CUDA安装程序

此时,CUDA已成功安装。然而,我有一些实用技巧

要分享,以帮助您更好地利用强大的独立显卡来运行大型模型。

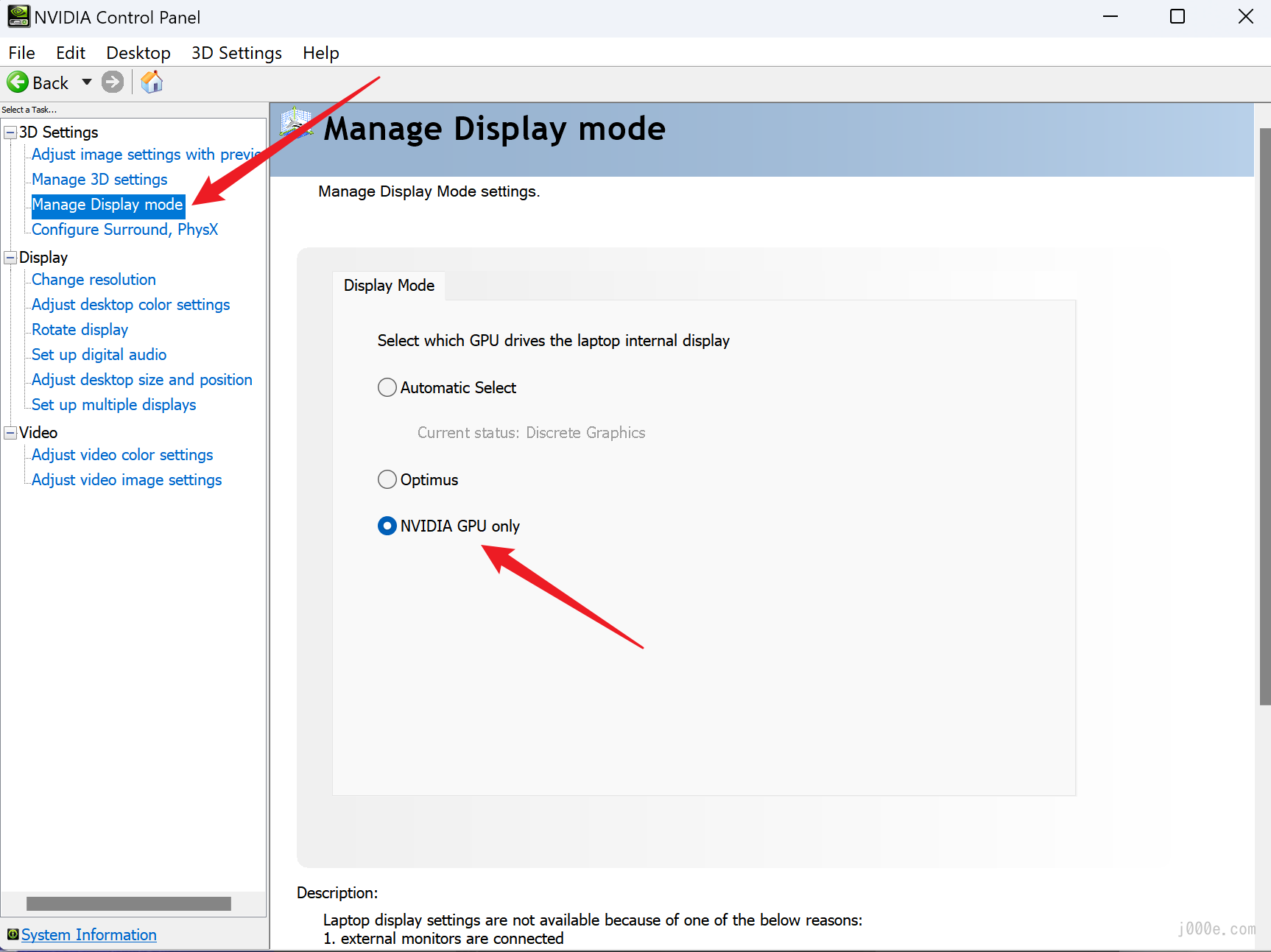

Ollama将自动检测并使用GPU运行模型,但如果您的计算机有多个GPU,可能会使用错误的一个。确保Ollama使用独立GPU的最简单直接的方法是在Nvidia控制面板中将显示模式设置为仅Nvidia GPU。如图所示,您可以在系统托盘中找到Nvidia控制面板,或右键点击桌面。

请注意,管理显示模式功能并非在每台计算机上都可用。如果您没有类似设置,不用担心,这不会影响您使用Ollama。

Nvidia控制面板 - 管理显示模式

注意:当您的计算机连接外部显示器时,可能无法调整显示模式。您需要断开所有外部显示器才能更改模式。

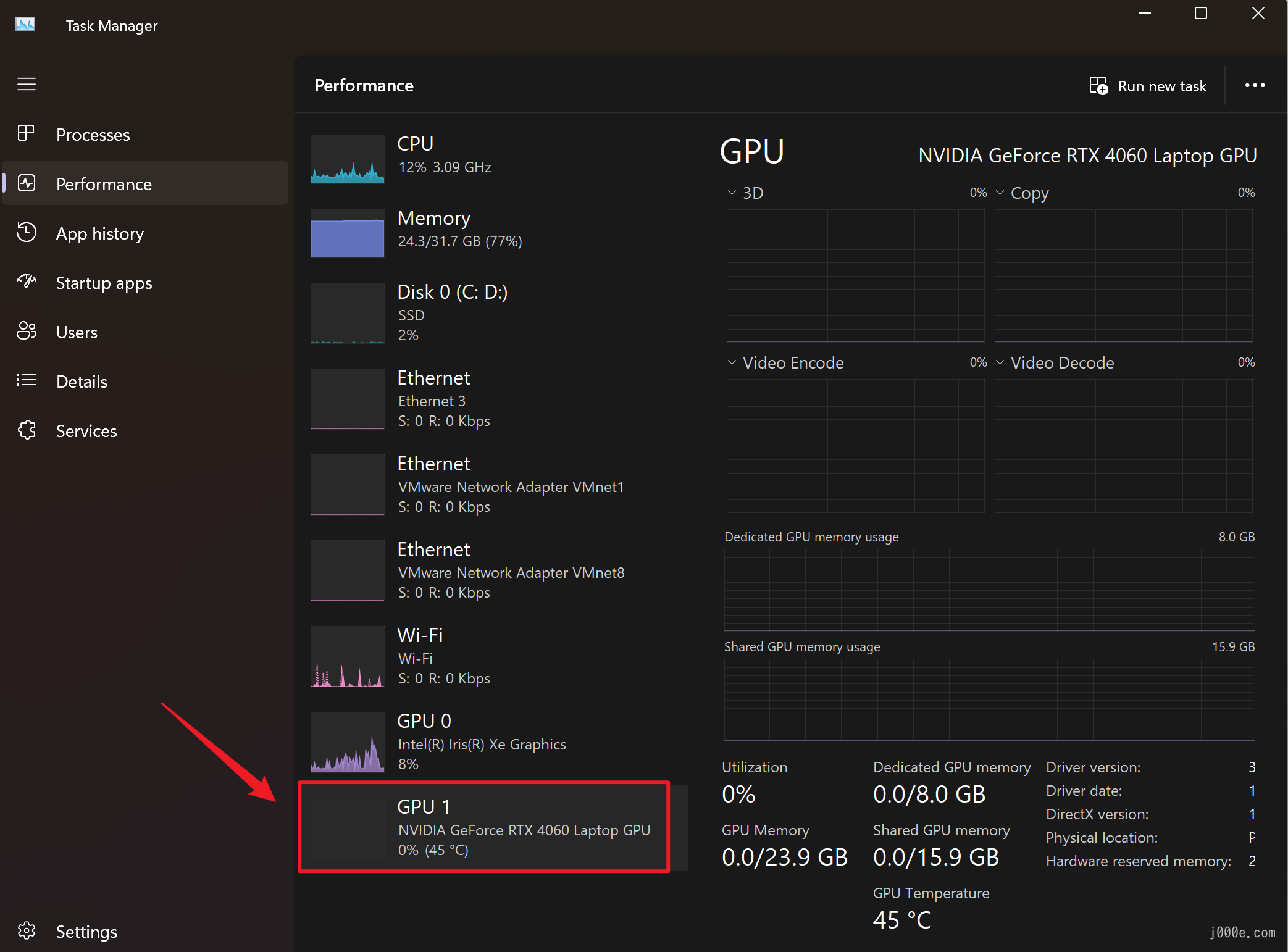

如何确认Ollama使用正确的GPU运行模型?

您可以开始运行一个模型,并询问它一个需要长时间回答的问题(例如“写一篇1000字的关于人工智能的文章”)。当它在响应时,打开一个新的命令行窗口并运行ollama ps,以检查Ollama是否使用了GPU以及使用率。此外,您可以使用Windows任务管理器监控GPU使用率和内存使用情况,以确定Ollama正在使用哪种硬件进行推理。

例如,Ollama显示它正在充分利用GPU,但未指定使用哪一个GPU。我们只能确认它没有使用CPU:

C:\Users\Edd1e>ollama ps

NAME ID SIZE PROCESSOR UNTIL

llama3:latest 365c0bd3c000 6.7 GB 100% GPU 4 minutes from now您可以使用Ctrl+Shift+Esc快捷键打开任务管理器,并检查性能选项卡。如果Ollama正在使用独立GPU,您将在图示部分看到一些使用情况:

任务管理器

高级用法

从GGUF导入

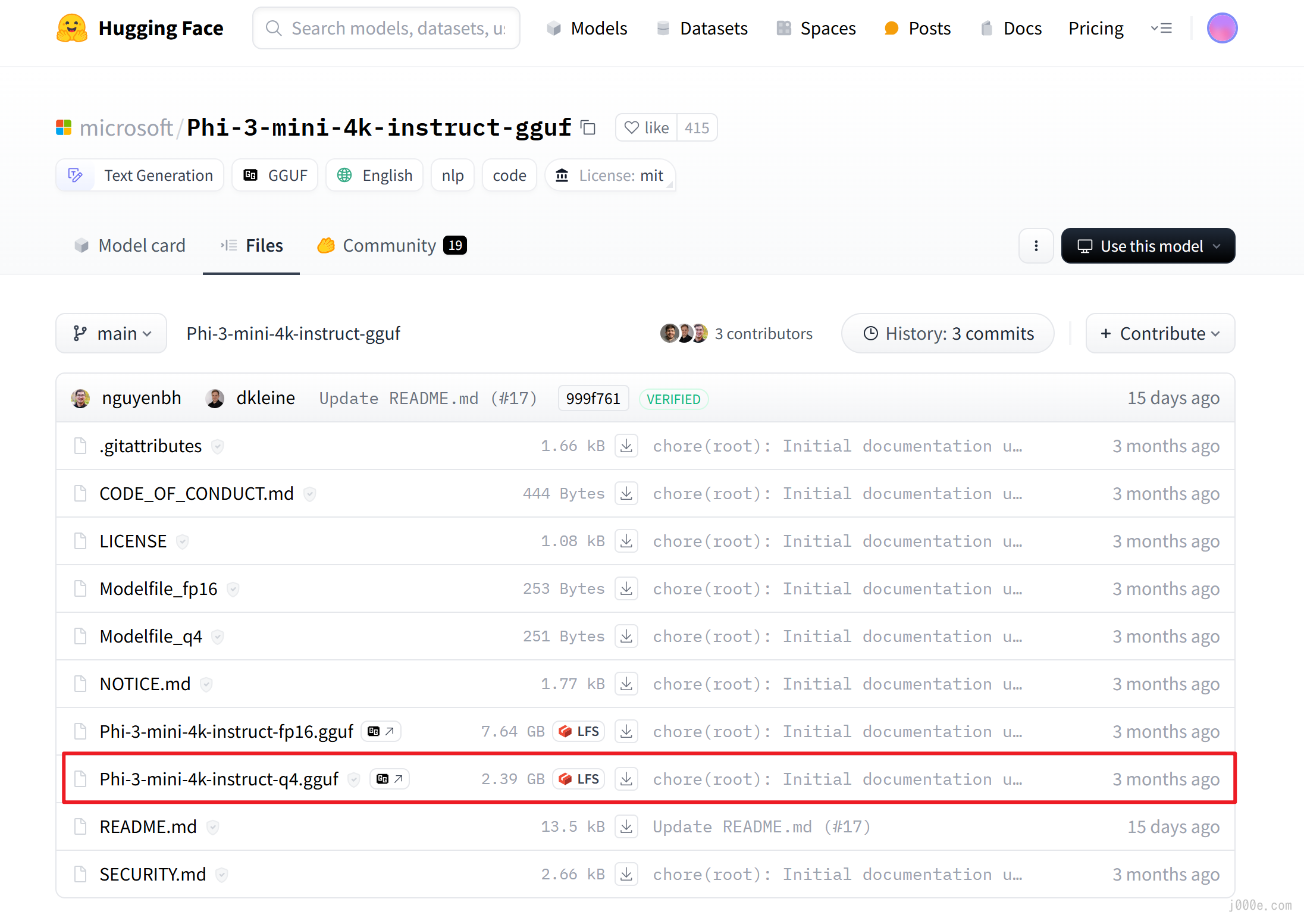

Ollama支持在模型文件中导入GGUF模型。您可以从Hugging Face等平台下载微调的GGUF模型,并通过Ollama运行它们。为此,您可以:

创建一个名为

Modelfile的文件,使用FROM指令指定要导入的模型的本地文件路径。FROM ./filename.gguf例如,您可以使用文本编辑器创建一个新文本文档,并输入以下内容。保存文档,然后重命名以移除文件扩展名如“.txt”:

FROM "D:\Joe\Downloads\microsoft\Phi-3-mini-4k-instruct-gguf\Phi-3-mini-4k-instruct-q4.gguf"Phi 3模型来自microsoft/Phi-3-mini-4k-instruct-gguf的Hugging Face页面。

Hugging Face Phi 3 页面

在Ollama中创建模型并命名为“example”:

ollama create example -f Modelfile示例:

ollama create example -f "D:\Joe\Downloads\Modelfile"运行模型:

ollama run example示例:

C:\Users\Edd1e>ollama run example >>> who are you? I am Phi, an AI developed by Microsoft to assist users in generating human-like text based on the input provided. How can I help you today?

自定义提示

可以使用Ollama库中的模型进行提示自定义。例如,要自定义llama3模型:

ollama pull llama3创建一个Modelfile:

FROM llama3

# 设置温度为1(温度越高,创意越强,温度越低,连贯性越强)

PARAMETER temperature 1

# 设置系统消息

SYSTEM """

You are a research assistant from Meta named Joe. You like AI technology and studying in Australia. Answer as a research assistant, only.

"""接下来,创建并运行模型:

ollama create Joe -f "D:\Joe\Downloads\Modelfile"

ollama run Joe

>>> hi

G'day! Hi there! I'm Joe, a research assistant from Meta. Nice to meet you! I'm

passionate about exploring the possibilities of artificial intelligence and how it can shape our world for the

better. When I'm not working on projects or staying up-to-date with the latest AI developments, you can find me

exploring the beautiful Australian landscape or hitting the books at one of our top-notch universities here. What

brings you to this neck of the woods?使用Ollama像GPT一样:在Docker中打开WebUI

本章将安装Docker并使用开源前端扩展Open WebUI连接到Ollama的API,最终创建类似于GPT的用户友好型聊天机器人体验。

Open WebUI是一个可扩展、功能丰富且用户友好的自托管WebUI,设计为完全离线运行。它支持各种LLM运行器,包括Ollama和兼容OpenAI的API。

Docker是一个开源平台,旨在通过容器化自动化应用程序的部署、扩展和管理。容器将应用程序及其所有依赖项打包在一起,确保在多个环境中保持一致。这使得开发、测试和部署过程更加高效。

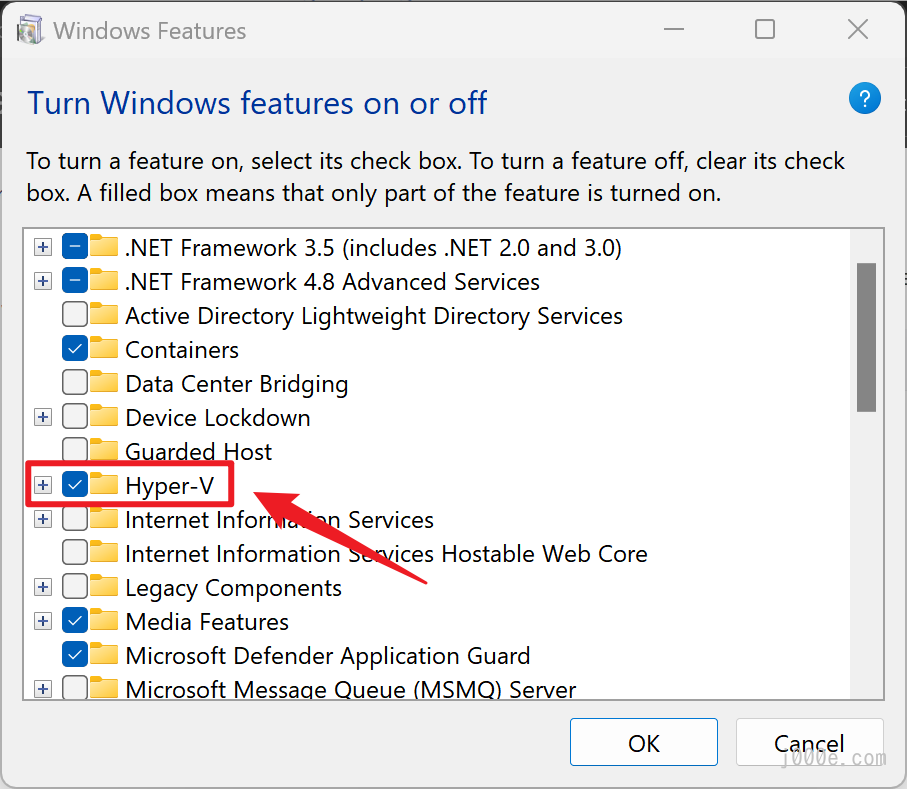

步骤1:启动Hyper-V

如果您之前未安装Docker,则需要先进行设置。

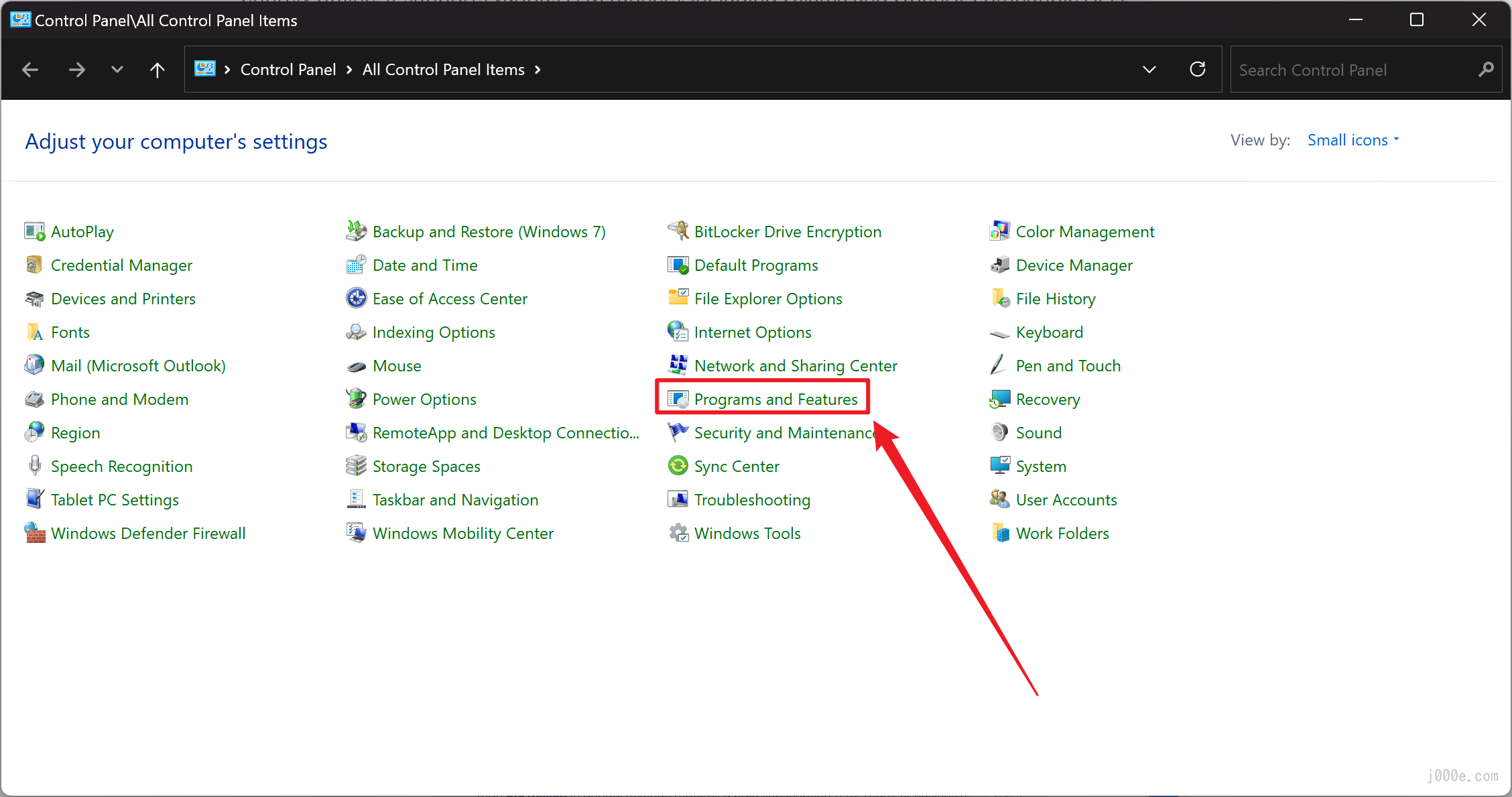

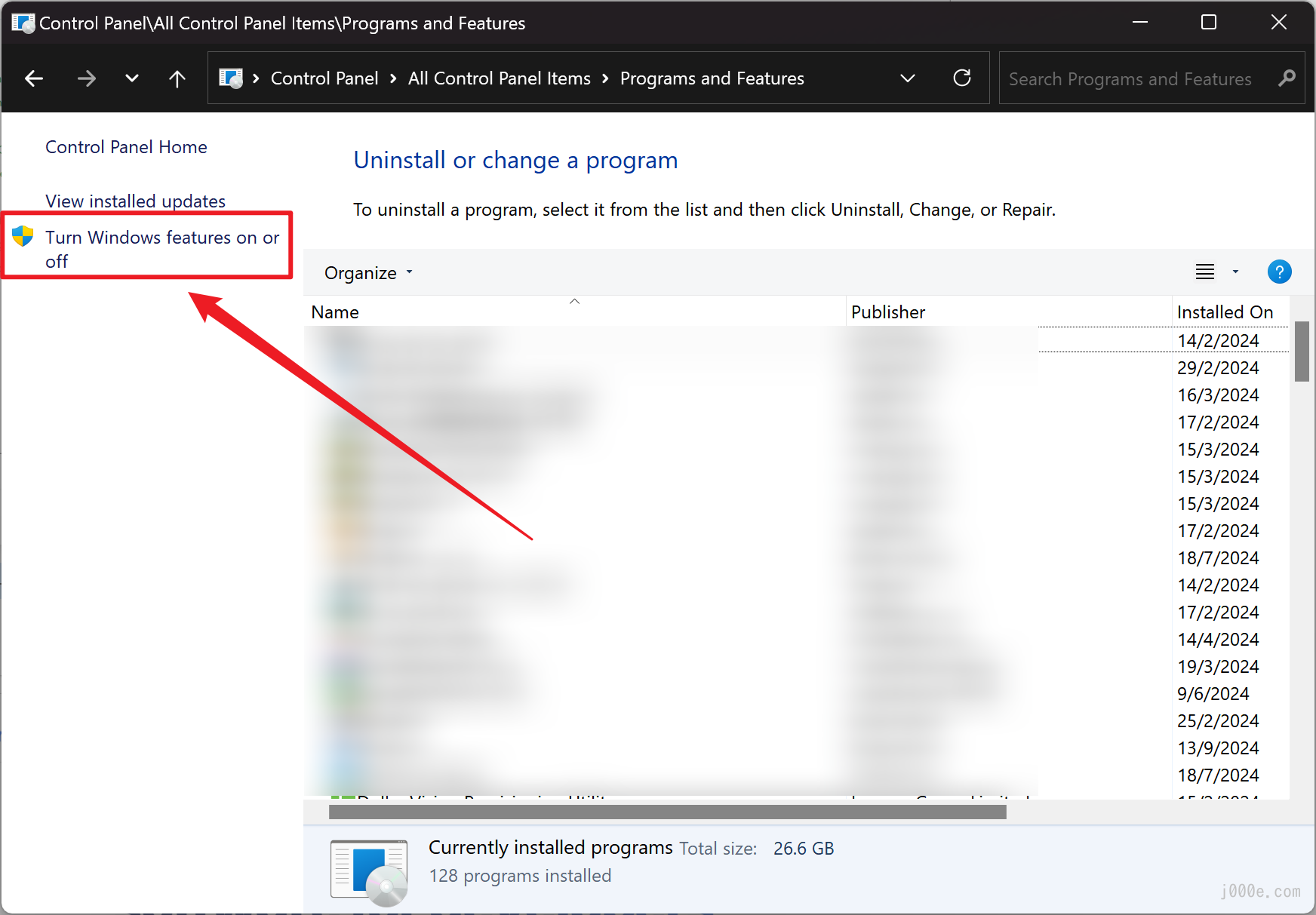

打开控制面板 > 程序 > 程序和功能 > 启用或关闭Windows功能

控制面板 - 程序和功能

启用或关闭Windows功能

勾选Hyper-V、虚拟机平台和Windows子系统Linux,然后点击确定。

完成后重启计算机。

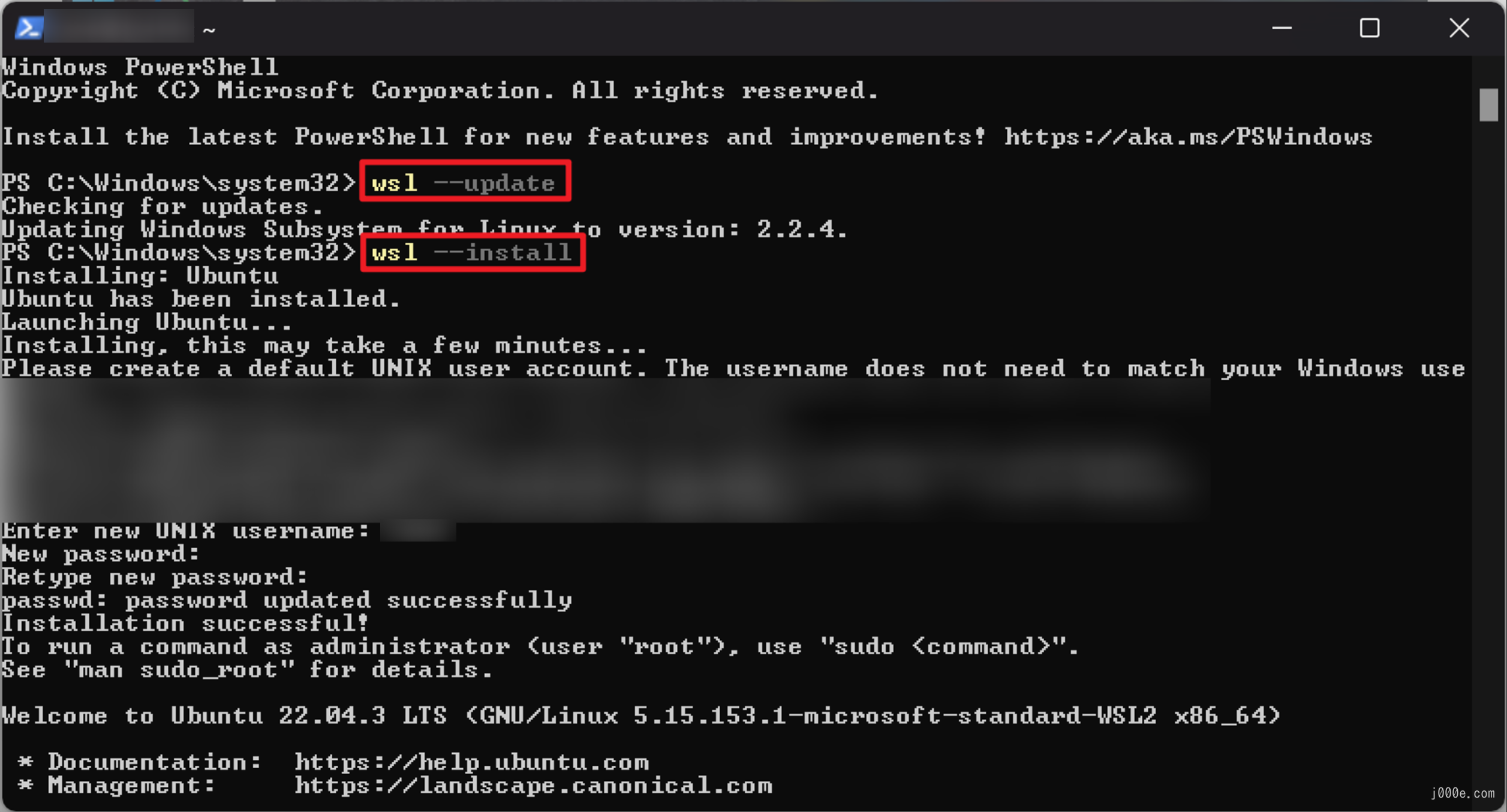

步骤2:安装WSL

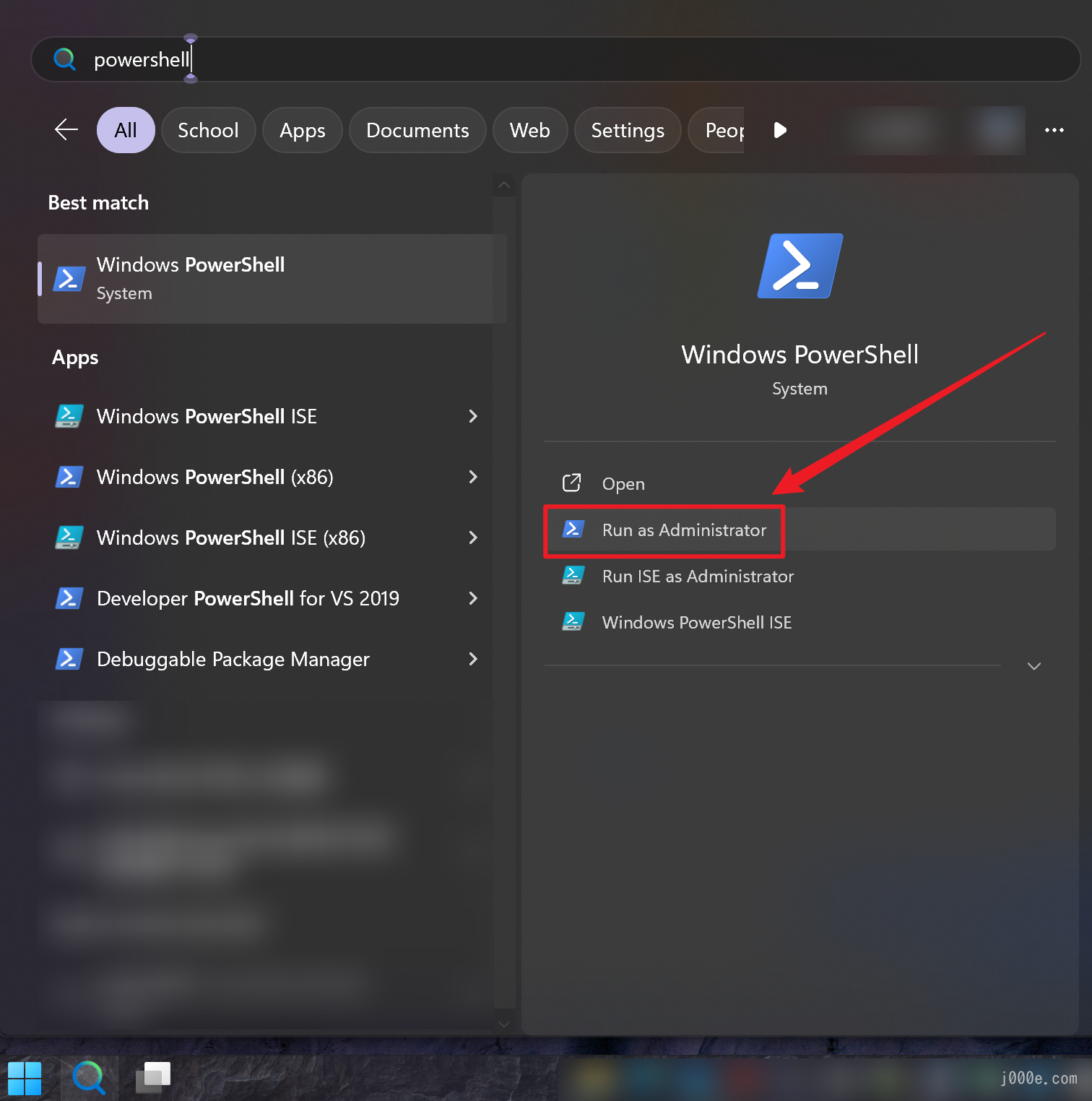

打开PowerShell并以管理员身份启动命令窗口。

输入:

wsl --update安装并设置您的Unix用户名和密码:

wsl --install

安装成功后重启计算机。

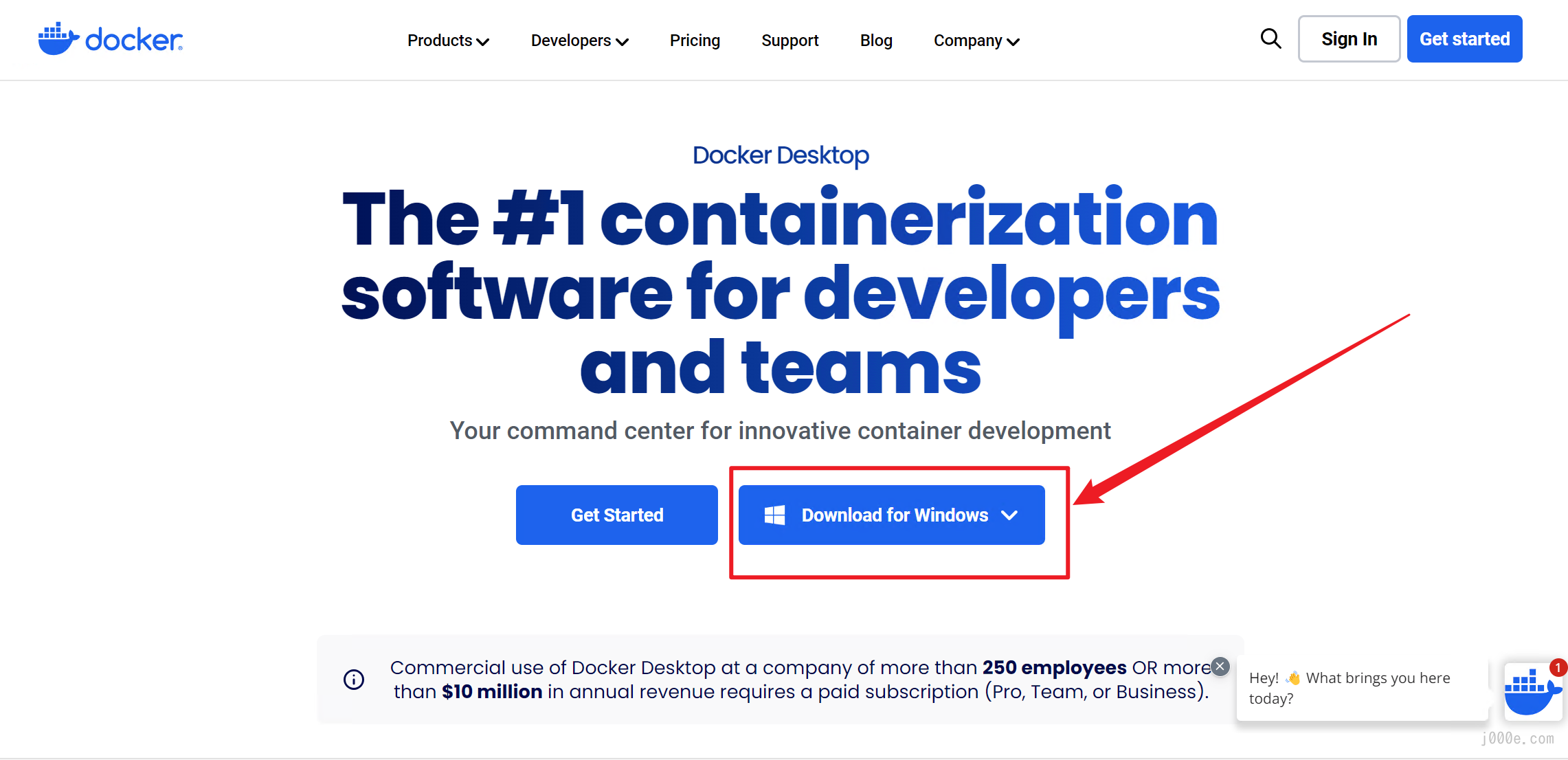

开始Docker安装。

首先,我们将安装Docker Desktop,可以从官方网站下载:

https://www.docker.com/products/docker-desktop/

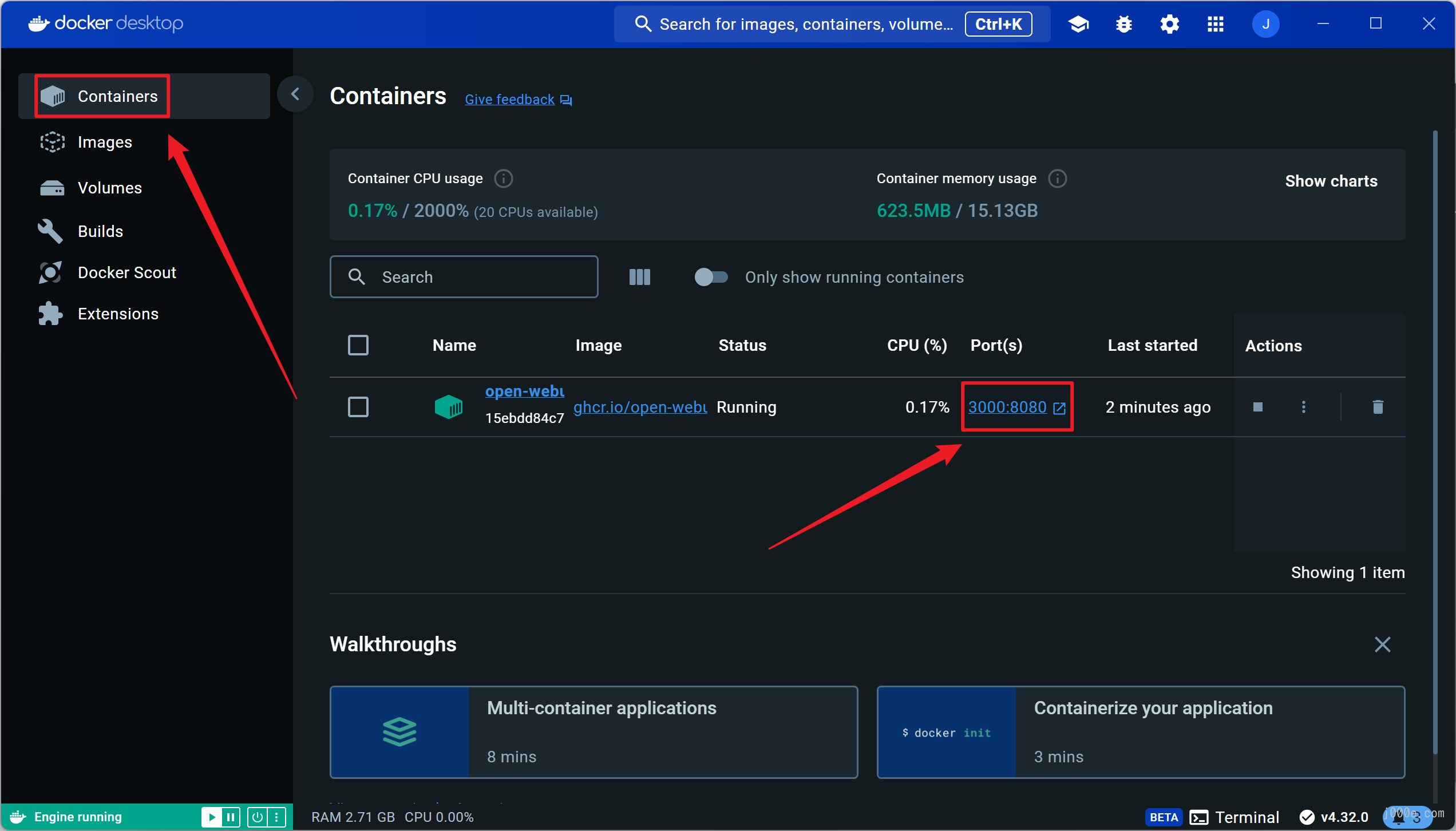

按照说明完成安装。安装完成后,启动Docker Desktop并在命令行或PowerShell中运行以下命令以拉取Open WebUI镜像:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main拉取完成后,您可以在容器选项卡下看到正在运行的容器。点击端口部分的链接以打开网页:

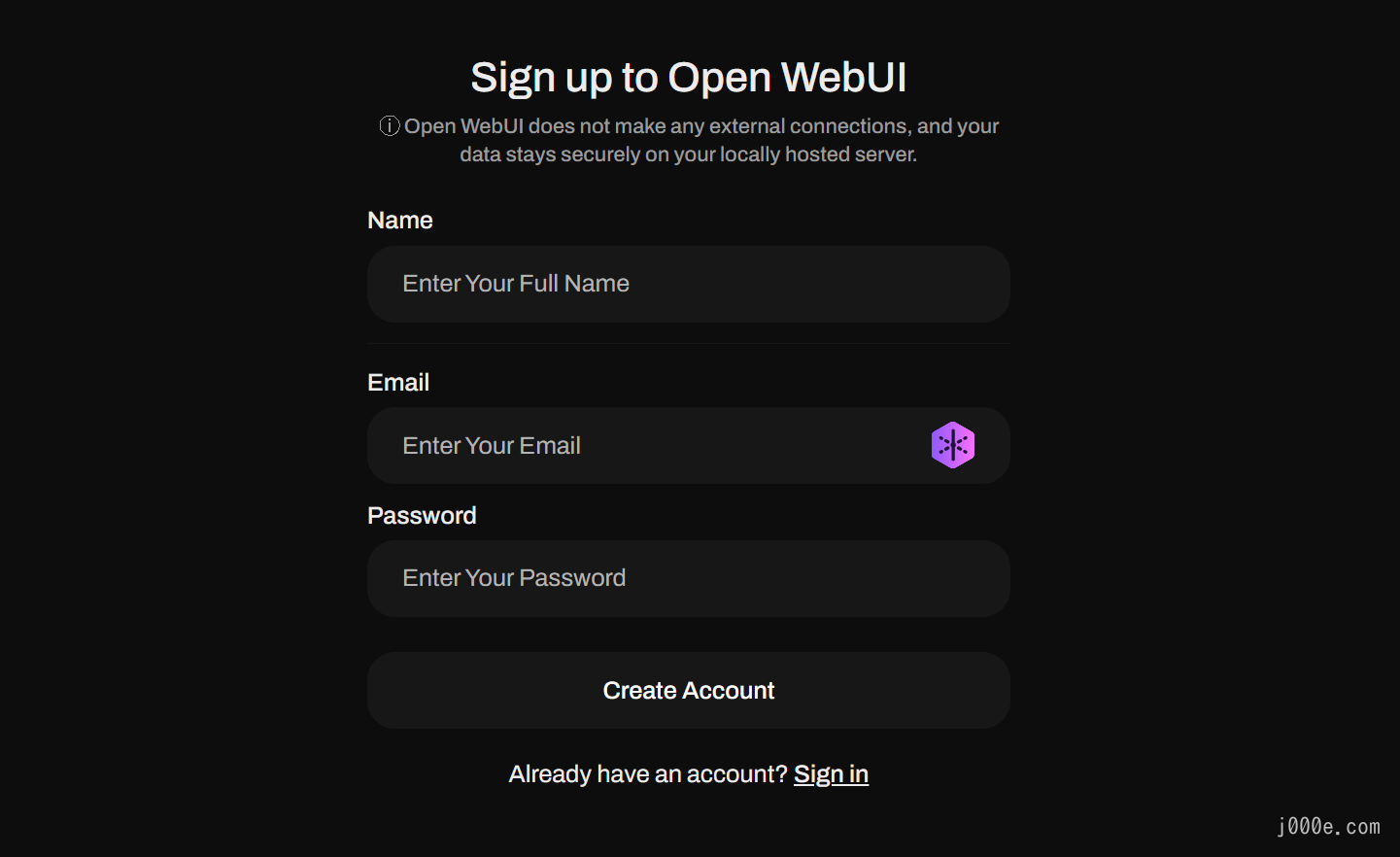

如果看到此页面,说明您已成功。接下来,点击“Sign up”注册账号:

填写信息完成注册:

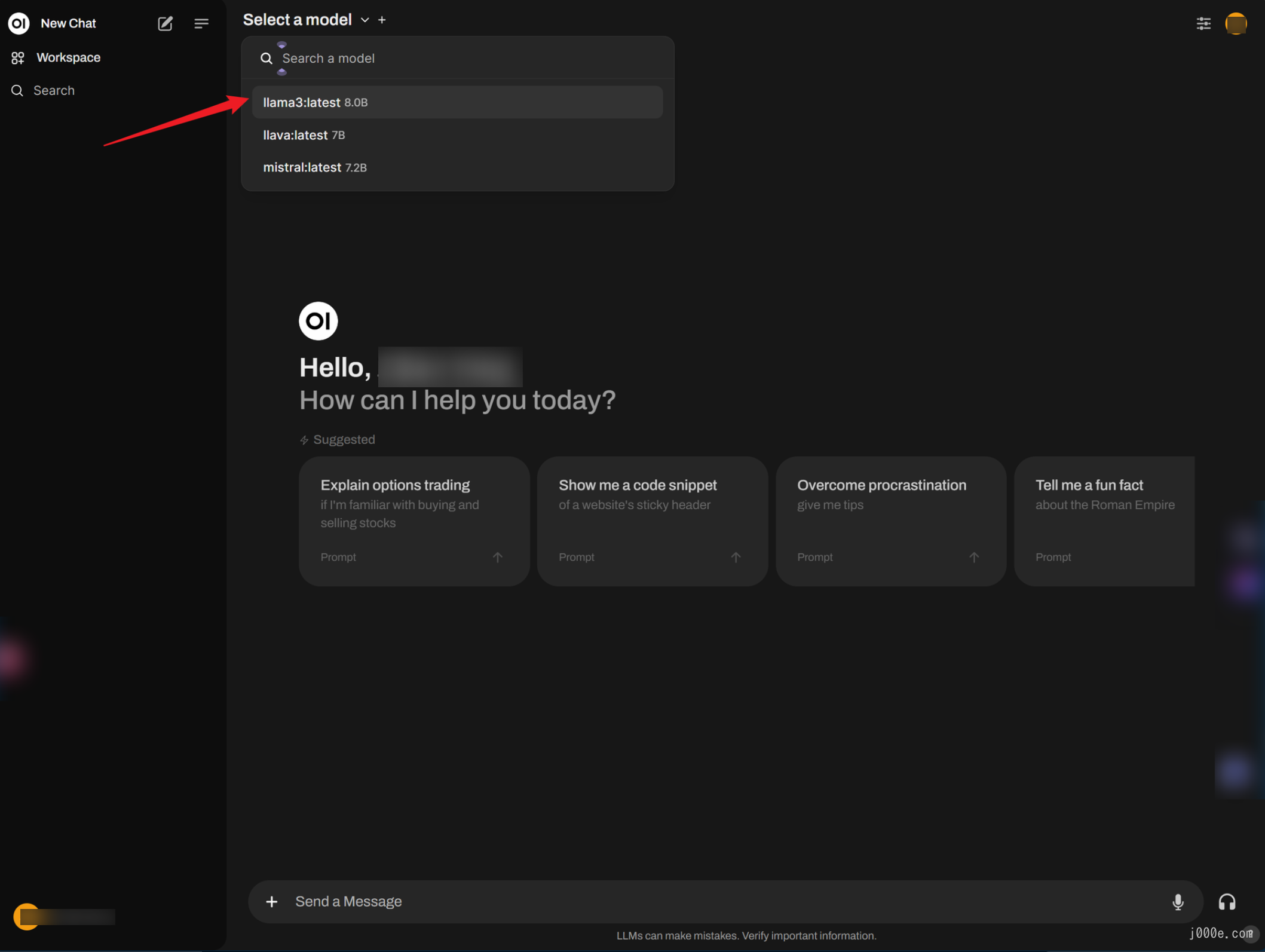

登录后,您可以从左上角选择一个模型。例如,我们选择Llama3:

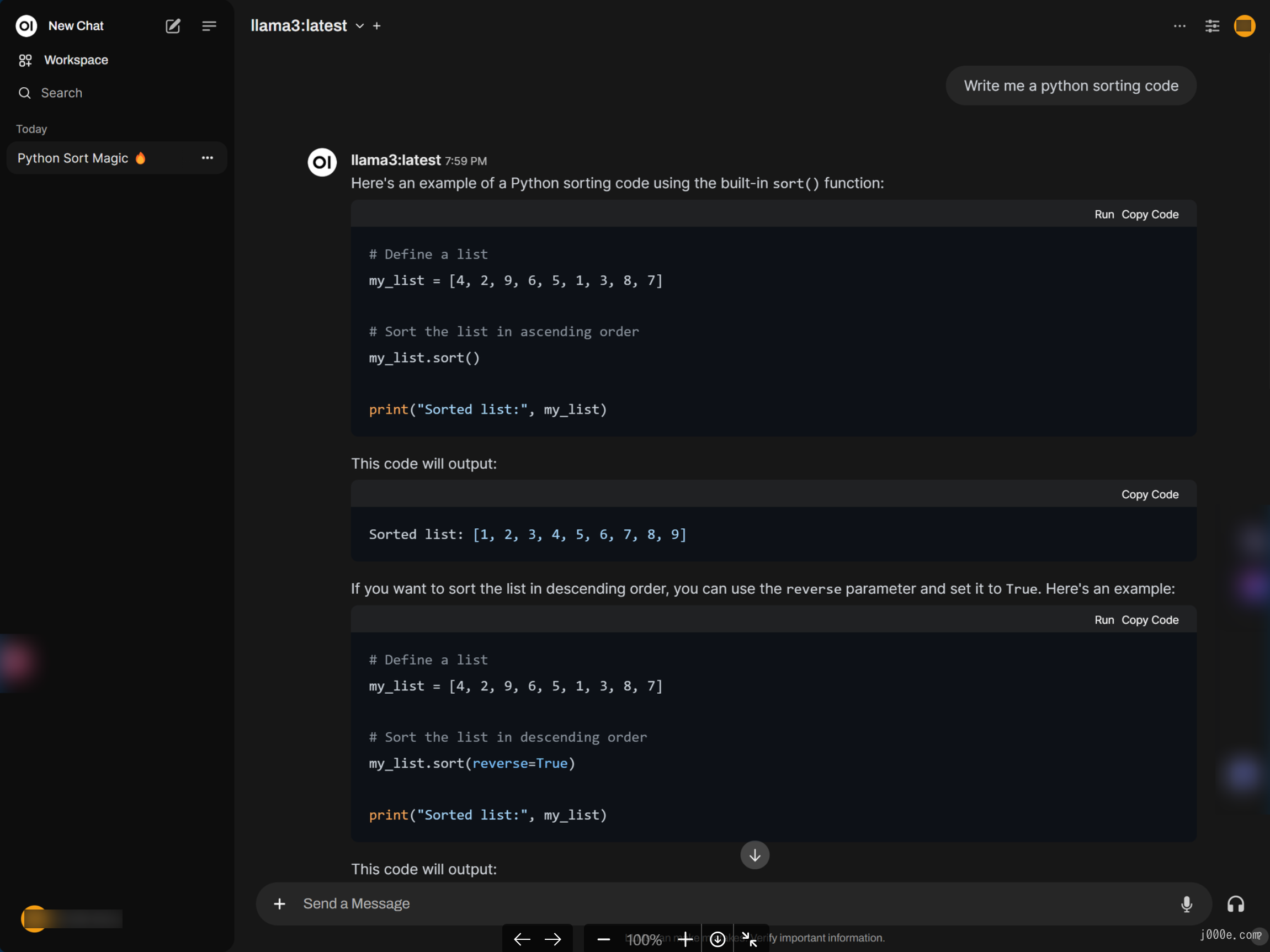

您会注意到,界面设计和交互非常类似于GPT,非常用户友好。它还很好地呈现了Markdown:

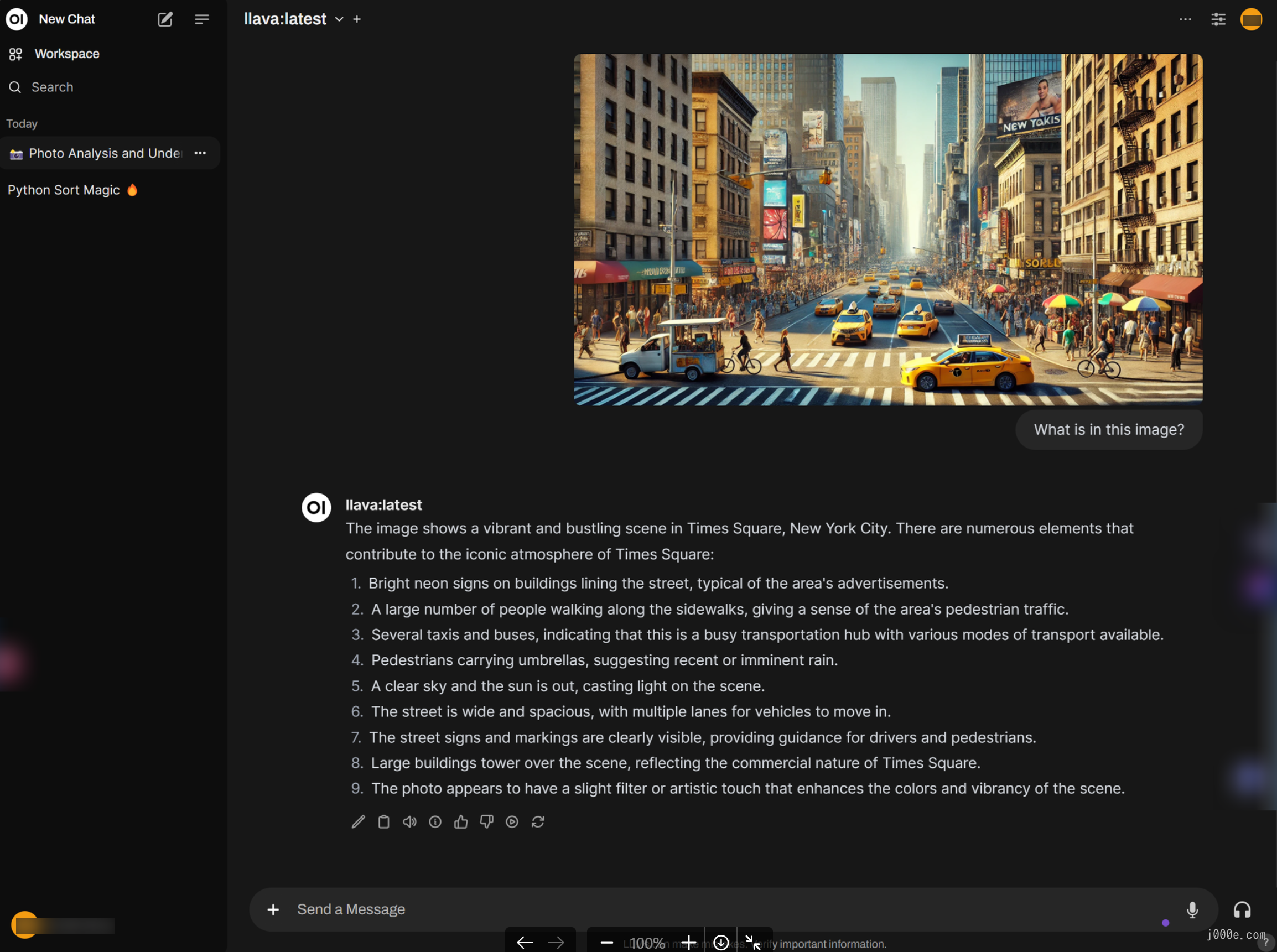

如果选择LLaVA模型,您可以直接粘贴图像,相比填入路径更加直观方便:

至此,我们已经完成了前端页面的部署。这使得使用起来更加方便和美观,让开源大型模型在本地运行具有完美的用户体验。

结论

在本指南中,我们逐步讲解了在Windows上安装和使用Ollama的过程,突出了其简单的设置和强大的功能。通过遵循提供的步骤,您可以轻松地在本地部署和管理大型语言模型,受益于GPU加速并确保您的数据保持私密。

Ollama简化了像Llama 3这样的预构建模型的使用,并允许使用GGUF模型进行自定义。此外,您还可以探索高级功能,如通过Docker集成实现的基于Web的界面,提供类似于流行AI聊天机器人的用户友好型聊天体验。

本指南还介绍了根据您的特定需求自定义提示和环境变量,使Ollama成为AI开发的多功能工具。凭借其全面的文档和对各种模型的支持,Ollama为任何希望利用大型语言模型强大功能的人提供了强大的解决方案。

通过本指南,您现在应该对如何使用Ollama有了全面的了解,并准备好开始您的探索和开发之旅。

来源

- https://github.com/ollama/ollama

- https://ollama.com/

- https://docs.nvidia.com/datacenter/cloud-native/container-toolkit/latest/install-guide.html

- https://github.com/ollama/ollama/blob/main/docs/faq.md#where-are-models-stored

- https://github.com/open-webui/open-webui

- https://www.docker.com/products/docker-desktop/

- https://docs.openwebui.com/

- https://huggingface.co/microsoft/Phi-3-mini-4k-instruct-gguf

One comment

您好,請問若是忘記openweb ui的密碼該怎麼辦?

openweb ui 要連免費API key URL該怎麼設定呢? 謝謝

Add Connection